みなさんこんにちは。

私はLinuxのシステム管理者です。2015年に独立した専門のビザでロシアからオーストラリアに移動しましたが、記事では子豚をトラクターにする方法については触れません。 そのような記事はすでに十分です(それでも、興味があれば、これについても書きます)。オーストラリアでの私の仕事で、linux-opsエンジニアとして、1つのシステムから移行を開始した方法についてお話ししたいと思います。別の監視。 具体的には-Nagios => Icinga2。

この記事は、一部は技術的であり、一部は人々とのコミュニケーション、および文化と作業方法の違いに関連する問題に関するものです。

残念ながら、「code」タグはPuppetおよびyamlコードを強調表示しないため、「plaintext」を使用する必要がありました。

2016年12月21日の朝には何も悪いことはありませんでした。 私は、いつものように、営業日の前半に登録されていない匿名でHabrを読み、コーヒーを吸収して、 この記事に出会いました。

会社でNagiosが使用されていたので、二度と考えずに、Redmineでチケットを作成し、一般的なチャットにリンクを投げました。それが重要だと思ったからです。 このイニシアチブはオーストラリアでも罰せられるため、主任エンジニアは私がこの問題を発見してから私にこの問題を掛けました。

私たちの部門では、意見を述べる前に、選択が明らかであっても少なくとも1つの代替案を提案するのが慣習です。そのため、ロシアでは最後の仕事で自分の個人記録システムを持っていたので、一般的にどの監視システムが現在関連しているかをグーグルで調べました非常に原始的ですが、それでも非常に機能し、割り当てられたすべてのタスクを実行します。 Python、サンクトペテルブルク工科大学とメトロルール。 いいえ、地下鉄は吸います。 これは個人的な(11年間の作業)であり、別の記事に値しますが、現在ではありません。

私の現在の場所でインフラストラクチャ構成を変更するためのルールについて少し。 Puppet、Gitlab、およびインフラストラクチャの原則をコードとして使用しているため、次のことが可能です。

- 仮想マシン上のファイルを手動で変更することによる、SSHによる手動の変更はありません。 3年間の仕事で、これまで何度か、1週間前の最後の帽子を受け取りましたが、それが最後ではないと思います。 実際、設定の1行を修正し、サービスを再起動して、問題が解決したかどうかを確認します-10秒。 Gitlabに新しいブランチを作成し、変更をプッシュし、r10kがPuppetmasterで動作するのを待ち、Puppet --environment = mybranchを実行し、このすべてが機能するまで数分(最低5分)待ちます。

- 変更はGitlabでマージリクエストを作成することで行われ、チームの少なくとも1人のメンバーから承認を得る必要があります。 チームリーダーの大幅な変更には、2〜3回の承認が必要です。

- すべての変更は何らかの形でテキスト形式であり(Puppetマニフェスト、Hieraスクリプトおよびデータはテキストであるため)、バイナリファイルは非常に推奨されておらず、そのようなファイルを承認するには正当な理由が必要です。

だから、私が見たオプション:

- Munin-インフラストラクチャに10を超えるサーバーがある場合、管理は地獄になります( この記事から。これを確認する意欲はあまりなかったので、その言葉を受け取りました)。

- Zabbix-長い間、ロシアに戻ってきましたが、それは私の仕事にとって冗長でした。 ここで-Puppetを構成マネージャーとして使用し、Gitlabをバージョン管理システムとして使用したため、削除する必要がありました。 当時、私が理解したように、Zabbixは構成全体をデータベースに保存するため、現在の状態で構成を管理する方法と変更を追跡する方法が明確ではありませんでした。

- プロメテウスは、部門の雰囲気から判断すると、最終的に来るものですが、当時はそれを習得できず、実際に動作するサンプル(Proof of Concept)を示すことができなかったため、拒否しなければなりませんでした。

- システムの完全な再設計を必要とする、または初期段階にある/放棄されていて、同じ理由で拒否された他のオプションがいくつかありました。

最後に、3つの理由からIcinga2に決めました。

1-Nrpe(Nagiosからのコマンドのチェックを実行するクライアントサービス)との互換性。 これは非常に重要でした。当時、私たちは135個(現在は165個)の自己作成サービス/チェックを備えた仮想マシンがあり、これをすべてやり直すとひどいhemoになるからです。

2-すべての構成ファイルはテキストであるため、この問題を簡単に編集したり、追加または削除された内容を確認できるマージ要求を作成したりできます。

3は活発で成長しているオープンソースプロジェクトです。 私たちはOpenSourceが非常に好きで、プルリクエストと問題を作成して問題を解決することで、それに対して実現可能な貢献をしています。

それでは、Icinga2に行きましょう。

最初に直面しなければならなかったのは、同僚の慣性でした。 誰もがNagios / Najios(ここでも発音の仕方について妥協することはできませんでしたが)とCheckMKインターフェースに慣れています。 icingaインターフェースはまったく異なって見えます(マイナスでした)が、文字通り任意のパラメーターを使用してフィルターで表示する必要があるものを柔軟に構成することができます(プラスでしたが、私は特にそれのために戦いました)。

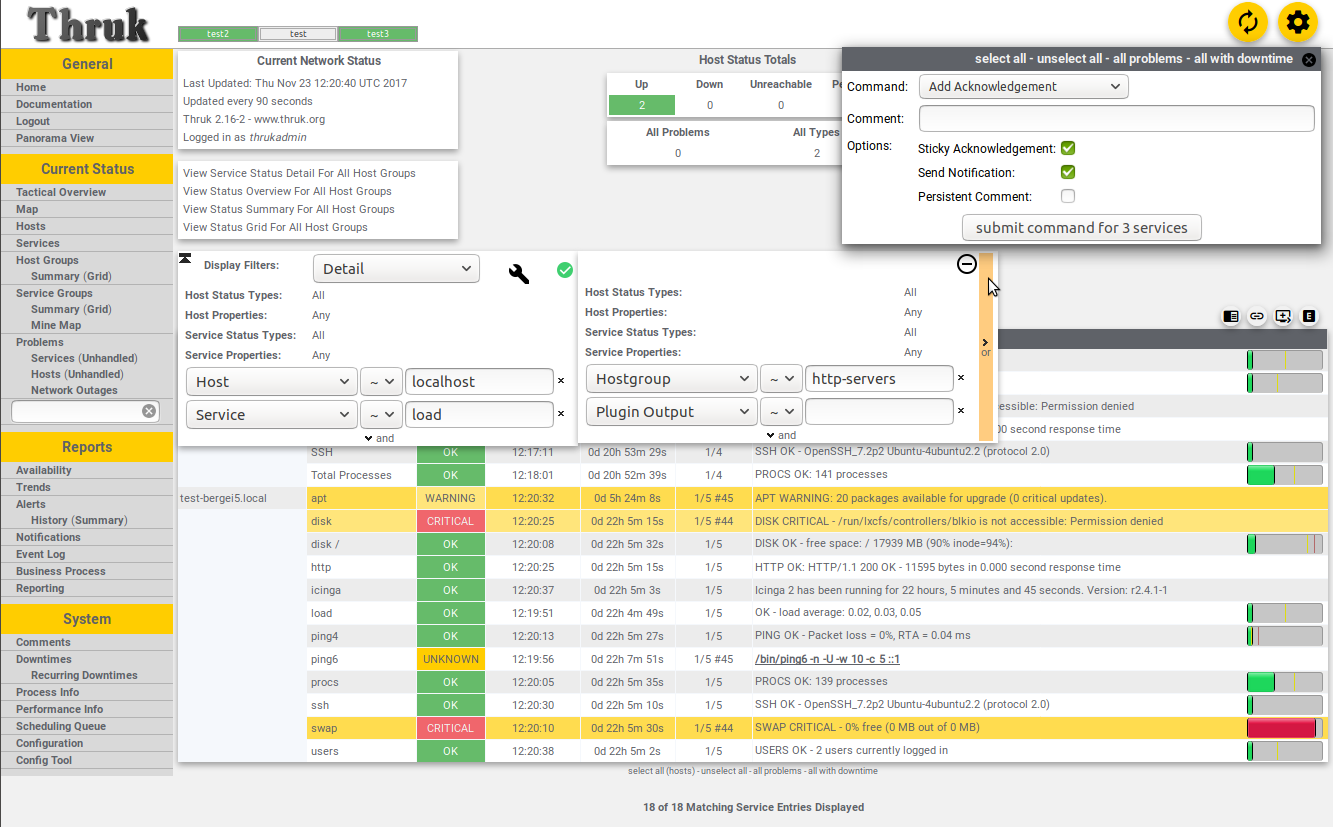

スクロールバーのサイズとスクロールフィールドのサイズの比率を見積もります。

次に、CheckMkを使用すると複数のNagiosホストを操作できるため、誰もが1つのモニターでインフラストラクチャ全体を見ることに慣れていますが、Icingaはその方法を知りませんでした(実際には、以下で詳しく説明します)。 代替手段はThrukと呼ばれるものでしたが、その設計により、チームメンバー全員を嘔吐させました。

ブレインストームの数日後、生産ゾーンに1つのマスターホストと2つの部下がいる場合のクラスターモニタリングのアイデアを提案しました。1つは開発/テストに、もう1つは別のプロバイダーに配置された外部ホストです。オブザーバー。 この構成により、1つのWebベースのインターフェイスですべての問題を確認でき、非常にうまく機能しましたが、Puppet ... (dev-test、staging-prod、ext)、Icinga APIを介した変更の送信には数秒かかりますが、すべてのホストのすべてのサービスのPuppetディレクトリのコンパイルには数分かかります。 これは今でも私を非難していますが、すべてがどのように機能し、なぜすべてが非常に時間がかかるのかを何度か説明しています。

第三-スノーフレーク(スノーフレーク)の束-特別な何かがあるため、一般的なシステムからノックアウトされたもの。一般的なルールは適用されません。 それは正面攻撃によって解決されました-アラームが存在する場合、実際にはすべてが正常である場合、ここであなたはより深く掘り下げて、それが私に警告するべきではない理由を理解する必要があります。 またはその逆-Nagiosがパニックに陥るが、Icingaはパニックに陥らない理由。

4番目に、Nagiosは3年間ここで働いており、最初は私の新しい流行のヒップスターシステムよりも彼に信頼があったので、Icingaがパニックを起こすたびに、Nagiosが同じ問題に興奮するまで誰も何もしませんでした。 しかし、IcingaがNagiosよりも前に実際のアラームを発行することは非常にまれであり、これを深刻な妨害と考えています。これについては「結論」セクションで説明します。

その結果、主に「パリティチェック」のために、試運転が5か月以上遅延しました(2018年6月28日に予定-2018年12月3日)。過去数年間何も聞いていませんが、今では理由もなく批判を発しているので、なぜ彼らが私のパネルにないのかを説明し、「パリティチェックが完了しました」(すべてのサービス/チェックNagiosのサービスは、Icingaのサービス/チェックに対応しています)

実装:

1つ目は、Puppet Styleなどのコード対データ戦争です。 すべてのデータは、ここでは一般的にすべて、Hieraにあり、他には何もないはずです。 すべてのコードは.ppファイルにあります。 変数、抽象化、関数-すべてはppで行います。

その結果、SSL証明書の状態と有効性を監視する必要のある仮想マシン(執筆時点では165)と68のWebアプリケーションがあります。 ただし、historical核の歴史により、アプリケーションを監視するための情報は別のgitlabリポジトリから取得され、データ形式はPuppet 3から変更されていないため、設定がさらに難しくなります。

define profiles::services::monitoring::docker_apps( Hash $app_list, Hash $apps_accessible_from, Hash $apps_access_list, Hash $webhost_defaults, Hash $webcheck_defaults, Hash $service_overrides, Hash $targets, Hash $app_checks, ) { #### APPS #### $zone = $name $app_list.each | String $app_name, Hash $app_data | { $notify_group = { 'notify_group' => ($webcheck_defaults[$zone]['notify_group'] + pick($app_data['notify_group'], {} )) } # adds notifications for default group (systems) + any group defined in int/pm_docker_apps.eyaml $data = merge($webhost_defaults, $apps_accessible_from, $app_data) $site_domain = $app_data['site_domain'] $regexp = pick($app_data['check_regex'], 'html') # Pick a regex to check $check_url = $app_data['check_url'] ? { undef => { 'http_uri' => '/' }, default => { 'http_uri' => $app_data['check_url'] } } $check_regex = $regexp ?{ 'absent' => {}, default => {'http_expect_body_regex' => $regexp} } $site_domain.each | String $vhost, Hash $vdata | { # Split an app by domains if there are two or more $vhost_name = {'http_vhost' => $vhost} $vars = $data['vars'] + $vhost_name + $check_regex + $check_url $web_ipaddress = is_array($vdata['web_ipaddress']) ? { # Make IP-address an array if it's not, because askizzy has 2 ips and it's an array true => $vdata['web_ipaddress'], false => [$vdata['web_ipaddress']], } $access_from_zones = [$zone] + $apps_access_list[$data['accessible_from']] # Merge default zone (where the app is defined) and extra zones if they exist $web_ipaddress.each | String $ip_address | { # For each IP (if we have multiple) $suffix = length($web_ipaddress) ? { # If we have more than one - add IP as a suffix to this hostname to avoid duplicating resources 1 => '', default => "_${ip_address}" } $octets = split($ip_address, '\.') $ip_tag = "${octets[2]}.${octets[3]}" # Using last octet only causes a collision between nginx-vip 203.15.70.94 and ext. ip 49.255.194.94 $access_from_zones.each | $zone_prefix |{ $zone_target = $targets[$zone_prefix] $nginx_vip_name = "${zone_prefix}_nginx-vip-${ip_tag}" # If it's a host for ext - prefix becomes 'ext_' (ext_nginx-vip...) $nginx_host_vip = { $nginx_vip_name => { ensure => present, target => $zone_target, address => $ip_address, check_command => 'hostalive', groups => ['nginx_vip',], } } $ssl_vars = $app_checks['ssl'] $regex_vars = $app_checks['http'] + $vars + $webcheck_defaults[$zone] + $notify_group if !defined( Profiles::Services::Monitoring::Host[$nginx_vip_name] ) { ensure_resources('profiles::services::monitoring::host', $nginx_host_vip) } if !defined( Icinga2::Object::Service["${nginx_vip_name}_ssl"] ) { icinga2::object::service {"${nginx_vip_name}_ssl": ensure => $data['ensure'], assign => ["host.name == $nginx_vip_name",], groups => ['webchecks',], check_command => 'ssl', check_interval => $service_overrides['ssl']['check_interval'], target => $targets['services'], apply => true, vars => $ssl_vars } } if $regexp != 'absent'{ if !defined(Icinga2::Object::Service["${vhost}${$suffix} regex"]){ icinga2::object::service {"${vhost}${$suffix} regex": ensure => $data['ensure'], assign => ["match(*_nginx-vip-${ip_tag}, host.name)",], groups => ['webchecks',], check_command => 'http', check_interval => $service_overrides['regex']['check_interval'], target => $targets['services'], enable_flapping => true, apply => true, vars => $regex_vars } } } } } } } }

ホストとサービスの構成コードもひどく見えます:

class profiles::services::monitoring::config( Array $default_config, Array $hostgroups, Hash $hosts = {}, Hash $host_defaults, Hash $services, Hash $service_defaults, Hash $service_overrides, Hash $webcheck_defaults, Hash $servicegroups, String $servicegroup_target, Hash $user_defaults, Hash $users, Hash $oncall, Hash $usergroup_defaults, Hash $usergroups, Hash $notifications, Hash $notification_defaults, Hash $notification_commands, Hash $timeperiods, Hash $webhost_defaults, Hash $apps_access_list, Hash $check_commands, Hash $hosts_api = {}, Hash $targets = {}, Hash $host_api_defaults = {}, ) { # Profiles::Services::Monitoring::Hostgroup <<| |>> # will be enabled when we move to icinga completely #### APPS #### case $location { 'int', 'ext': { $apps_by_zone = {} } 'pm': { $int_apps = hiera('int_docker_apps') $int_app_defaults = hiera('int_docker_app_common') $st_apps = hiera('staging_docker_apps') $srs_apps = hiera('pm_docker_apps_srs') $pm_apps = hiera('pm_docker_apps') + $st_apps + $srs_apps $pm_app_defaults = hiera('pm_docker_app_common') $apps_by_zone = { 'int' => $int_apps, 'pm' => $pm_apps, } $app_access_by_zone = { 'int' => {'accessible_from' => $int_app_defaults['accessible_from']}, 'pm' => {'accessible_from' => $pm_app_defaults['accessible_from']}, } } default: { fail('Please ensure the node has $location fact set (int, pm, ext)') } } file { '/etc/icinga2/conf.d/': ensure => directory, recurse => true, purge => true, owner => 'icinga', group => 'icinga', mode => '0750', notify => Service['icinga2'], } $default_config.each | String $file_name |{ file {"/etc/icinga2/conf.d/${file_name}": ensure => present, source => "puppet:///modules/profiles/services/monitoring/default_config/${file_name}", owner => 'icinga', group => 'icinga', mode => '0640', } } $app_checks = { 'ssl' => $services['webchecks']['checks']['ssl']['vars'], 'http' => $services['webchecks']['checks']['http_regexp']['vars'] } $apps_by_zone.each | String $zone, Hash $app_list | { profiles::services::monitoring::docker_apps{$zone: app_list => $app_list, apps_accessible_from => $app_access_by_zone[$zone], apps_access_list => $apps_access_list, webhost_defaults => $webhost_defaults, webcheck_defaults => $webcheck_defaults, service_overrides => $service_overrides, targets => $targets, app_checks => $app_checks, } } #### HOSTS #### # Profiles::Services::Monitoring::Host <<| |>> # This is for spaceship invasion when it's ready. $hosts_has_large_disks = query_nodes('mountpoints.*.size_bytes >= 1099511627776') $hosts.each | String $hostgroup, Hash $list_of_hosts_with_settings | { # Splitting site lists by hostgroups - docker_host/gluster_host/etc $list_of_hosts_in_group = $list_of_hosts_with_settings['hosts'] $hostgroup_settings = $list_of_hosts_with_settings['settings'] $merged_hostgroup_settings = deep_merge($host_defaults, $list_of_hosts_with_settings['settings']) $list_of_hosts_in_group.each | String $host_name, Hash $host_settings |{ # Splitting grouplists by hosts # Is this host in the array $hosts_has_large_disks ? If so set host.vars.has_large_disks if ( $hosts_has_large_disks.reduce(false) | $found, $value| { ( $value =~ "^${host_name}" ) or $found } ) { $vars_has_large_disks = { 'has_large_disks' => true } } else { $vars_has_large_disks = {} } $host_data = deep_merge($merged_hostgroup_settings, $host_settings) $hostgroup_settings_vars = pick($hostgroup_settings['vars'], {}) $host_settings_vars = pick($host_settings['vars'], {}) $host_notify_group = delete_undef_values($host_defaults['vars']['notify_group'] + $hostgroup_settings_vars['notify_group'] + $host_settings_vars['notify_group']) $host_data_vars = delete_undef_values(deep_merge($host_data['vars'] , {'notify_group' => $host_notify_group}, $vars_has_large_disks)) # Merging vars separately $hostgroups = delete_undef_values([$hostgroup] + $host_data['groups']) profiles::services::monitoring::host{$host_name: ensure => $host_data['ensure'], display_name => $host_data['display_name'], address => $host_data['address'], groups => $hostgroups, target => $host_data['target'], check_command => $host_data['check_command'], check_interval => $host_data['check_interval'], max_check_attempts => $host_data['max_check_attempts'], vars => $host_data_vars, template => $host_data['template'], } } } if !empty($hosts_api){ # All hosts managed by API $hosts_api.each | String $zone, Hash $hosts_api_zone | { # Split api hosts by zones $hosts_api_zone.each | String $hostgroup, Hash $list_of_hosts_with_settings | { # Splitting site lists by hostgroups - docker_host/gluster_host/etc $list_of_hosts_in_group = $list_of_hosts_with_settings['hosts'] $hostgroup_settings = $list_of_hosts_with_settings['settings'] $merged_hostgroup_settings = deep_merge($host_api_defaults, $list_of_hosts_with_settings['settings']) $list_of_hosts_in_group.each | String $host_name, Hash $host_settings |{ # Splitting grouplists by hosts # Is this host in the array $hosts_has_large_disks ? If so set host.vars.has_large_disks if ( $hosts_has_large_disks.reduce(false) | $found, $value| { ( $value =~ "^${host_name}" ) or $found } ) { $vars_has_large_disks = { 'has_large_disks' => true } } else { $vars_has_large_disks = {} } $host_data = deep_merge($merged_hostgroup_settings, $host_settings) $hostgroup_settings_vars = pick($hostgroup_settings['vars'], {}) $host_settings_vars = pick($host_settings['vars'], {}) $host_api_notify_group = delete_undef_values($host_defaults['vars']['notify_group'] + $hostgroup_settings_vars['notify_group'] + $host_settings_vars['notify_group']) $host_data_vars = delete_undef_values(deep_merge($host_data['vars'] , {'notify_group' => $host_api_notify_group}, $vars_has_large_disks)) $hostgroups = delete_undef_values([$hostgroup] + $host_data['groups']) if defined(Profiles::Services::Monitoring::Host[$host_name]){ $hostname = "${host_name}_from_${zone}" } else { $hostname = $host_name } profiles::services::monitoring::host{$hostname: ensure => $host_data['ensure'], display_name => $host_data['display_name'], address => $host_data['address'], groups => $hostgroups, target => "${host_data['target_base']}/${zone}/hosts.conf", check_command => $host_data['check_command'], check_interval => $host_data['check_interval'], max_check_attempts => $host_data['max_check_attempts'], vars => $host_data_vars, template => $host_data['template'], } } } } } #### END OF HOSTS #### #### SERVICES #### $services.each | String $service_group, Hash $s_list |{ # Service_group and list of services in that group $service_list = $s_list['checks'] # List of actual checks, separately from SG settings $service_list.each | String $service_name, Hash $data |{ $merged_defaults = merge($service_defaults, $s_list['settings']) # global service defaults + service group defaults $merged_data = merge($merged_defaults, $data) $settings_vars = pick($s_list['settings']['vars'], {}) $this_service_vars = pick($data['vars'], {}) $all_service_vars = delete_undef_values($service_defaults['vars'] + $settings_vars + $this_service_vars) # If we override default check_timeout, but not nrpe_timeout, make nrpe_timeout the same as check_timeout if ( $merged_data['check_timeout'] and ! $this_service_vars['nrpe_timeout'] ) { # NB: Icinga will convert 1m to 60 automatically! $nrpe = { 'nrpe_timeout' => $merged_data['check_timeout'] } } else { $nrpe = {} } # By default we use nrpe and all commands are run via nrpe. So vars.nrpe_command = $service_name is a default value # If it's server-side Icinga command - we don't need 'nrpe_command' # but there is no harm to have that var and the code is shorter if $merged_data['check_command'] == 'nrpe'{ $check_command = $merged_data['vars']['nrpe_command'] ? { undef => { 'nrpe_command' => $service_name }, default => { 'nrpe_command' => $merged_data['vars']['nrpe_command'] } } }else{ $check_command = {} } # Assembling $vars from Global Default service settings, servicegroup settings, this particular check settings and let's not forget nrpe settings. if $all_service_vars['graphite_template'] { $graphite_template = {'check_command' => $all_service_vars['graphite_template']} }else{ $graphite_template = {'check_command' => $service_name} } $service_notify = [] + pick($settings_vars['notify_group'], []) + pick($this_service_vars['notify_group'], []) # pick is required everywhere, otherwise becomes "The value '' cannot be converted to Numeric" $service_notify_group = $service_notify ? { [] => $service_defaults['vars']['notify_group'], default => $service_notify } # Assing default group (systems) if no other groups are defined $vars = $all_service_vars + $nrpe + $check_command + $graphite_template + {'notify_group' => $service_notify_group} # This needs to be merged separately, because merging it as part of MERGED_DATA overwrites arrays instead of merging them, so we lose some "assign" and "ignore" values $assign = delete_undef_values($service_defaults['assign'] + $s_list['settings']['assign'] + $data['assign']) $ignore = delete_undef_values($service_defaults['ignore'] + $s_list['settings']['ignore'] + $data['ignore']) icinga2::object::service {$service_name: ensure => $merged_data['ensure'], apply => $merged_data['apply'], enable_flapping => $merged_data['enable_flapping'], assign => $assign, ignore => $ignore, groups => [$service_group], check_command => $merged_data['check_command'], check_interval => $merged_data['check_interval'], check_timeout => $merged_data['check_timeout'], check_period => $merged_data['check_period'], display_name => $merged_data['display_name'], event_command => $merged_data['event_command'], retry_interval => $merged_data['retry_interval'], max_check_attempts => $merged_data['max_check_attempts'], target => $merged_data['target'], vars => $vars, template => $merged_data['template'], } } } #### END OF SERVICES #### #### OTHER BORING STUFF #### $servicegroups.each | $servicegroup, $description |{ icinga2::object::servicegroup{ $servicegroup: target => $servicegroup_target, display_name => $description } } $hostgroups.each| String $hostgroup |{ profiles::services::monitoring::hostgroup { $hostgroup:} } $notifications.each | String $name, Hash $settings |{ $assign = pick($notification_defaults['assign'], []) + $settings['assign'] $ignore = pick($notification_defaults['ignore'], []) + $settings['ignore'] $merged_settings = $settings + $notification_defaults icinga2::object::notification{$name: target => $merged_settings['target'], apply => $merged_settings['apply'], apply_target => $merged_settings['apply_target'], command => $merged_settings['command'], interval => $merged_settings['interval'], states => $merged_settings['states'], types => $merged_settings['types'], assign => delete_undef_values($assign), ignore => delete_undef_values($ignore), user_groups => $merged_settings['user_groups'], period => $merged_settings['period'], vars => $merged_settings['vars'], } } # Merging notification settings for users with other settings $users_oncall = deep_merge($users, $oncall) # Magic. Do not touch. create_resources('icinga2::object::user', $users_oncall, $user_defaults) create_resources('icinga2::object::usergroup', $usergroups, $usergroup_defaults) create_resources('icinga2::object::timeperiod',$timeperiods) create_resources('icinga2::object::checkcommand', $check_commands) create_resources('icinga2::object::notificationcommand', $notification_commands) profiles::services::sudoers { 'icinga_runs_ping_l2': ensure => present, sudoersd_template => 'profiles/os/redhat/centos7/sudoers/icinga.erb', } }

私はまだこの麺に取り組んでおり、可能な限りそれを改善しています。 ただし、Hieraでシンプルで明確な構文を使用できるようにしたのは次のようなコードです。

profiles::services::monitoring::config::services: perf_checks: settings: check_interval: '2m' assign: - 'host.vars.type == linux' checks: procs: {} load: {} memory: {} disk: check_interval: '5m' vars: notification_period: '24x7' disk_iops: vars: notifications: - 'silent' cpu: vars: notifications: - 'silent' dns_fqdn: check_interval: '15m' ignore: - 'xenserver in host.groups' vars: notifications: - 'silent' iftraffic_nrpe: vars: notifications: - 'silent' logging: settings: assign: - 'logserver in host.groups' checks: rsyslog: {} nginx_limit_req_other: {} nginx_limit_req_s2s: {} nginx_limit_req_s2x: {} nginx_limit_req_srs: {} logstash: {} logstash_api: vars: notifications: - 'silent'

すべてのチェックはグループに分けられ、各グループには、これらのチェックを実行する場所と頻度、送信する通知、送信先などのデフォルト設定があります。

各チェックでは、任意のオプションをオーバーライドできます。これにより、最終的にすべてのチェック全体のデフォルト設定が追加されます。 したがって、このような麺はconfig.ppに書き込まれます。すべてのデフォルト設定とグループ設定が統合され、次に個々のチェックが統合されます。

また、非常に重要な変更は、設定で機能を使用する機能でした。たとえば、http_regexを確認するためにポート、アドレス、およびURLを変更する機能です。

http_regexp: assign: - 'host.vars.http_regex' - 'static_sites in host.groups' check_command: 'http' check_interval: '1m' retry_interval: '20s' max_check_attempts: 6 http_port: '{{ if(host.vars.http_port) { return host.vars.http_port } else { return 443 } }}' vars: notification_period: 'host.vars.notification_period' http_vhost: '{{ if(host.vars.http_vhost) { return host.vars.http_vhost } else { return host.name } }}' http_ssl: '{{ if(host.vars.http_ssl) { return false } else { return true } }}' http_expect_body_regex: 'host.vars.http_regex' http_uri: '{{ if(host.vars.http_uri) { return host.vars.http_uri } else { return "/" } }}' http_onredirect: 'follow' http_warn_time: 8 http_critical_time: 15 http_timeout: 30 http_sni: true

つまり、ホスト定義にhttp_port変数がある場合はそれを使用し、そうでない場合は443を使用します。たとえば、jabber Webインターフェースは9090でハングし、Unifiは7443でハングします。

http_vhostは、DNSを無視してこのアドレスを取ることを意味します。

ホストでuriが指定されている場合は、それに沿って進み、そうでない場合は「/」を使用します。

http_sslで面白い話が出ました-この感染はオンデマンドで切断したくありませんでした。 ホスト定義の変数が次のようになってしまうまで、私は長い間この行につまずいた。

http_ssl: false

式に代入する

if(host.vars.http_ssl) { return false } else { return true }

偽として、それは判明

if(false) { return false } else { return true }

つまり、SSLチェックは常にアクティブです。 構文を置き換えることで決定されました。

http_ssl: no

結論 :

長所:

- 現在、監視システムは1つであり、過去7〜8か月のように2つではありませんでした。

- ホスト/サービス(チェック)のデータ構造は、(私の意見では)より読みやすく、理解しやすいものになりました。 他の人にとっては、これはそれほど明白ではなかったので、ローカルWikiでいくつかのページをカットして、それがどのように機能し、何を編集するかを説明する必要がありました。

- 変数と関数を使用してチェックを柔軟に構成することができます。たとえば、http_regexpをチェックし、目的のパターン、戻りコード、URL、ポートをホスト設定で設定できます。

- いくつかのダッシュボードがあり、それぞれについて、表示されたアラームの独自のリストを定義し、Puppetおよびマージ要求を介してすべてを管理できます。

短所:

- チームメンバーの慣性-Nagiosは働き、働き、働きましたが、これはあなたのIsingaが常にバグを起こし、遅くなります。 そして、どうすれば物語を見ることができますか? そして、いまいましい、それは更新されません...(本当の問題は、アラーム履歴がF5によってのみ自動的に更新されないことです)

- システムの慣性-Webインターフェイスで[今すぐ確認]をクリックすると、実行結果は火星の天気、特に完了に数十秒かかる複雑なサービスに依存します。 同様の結果は正常です。

- 一般的に、並んで動作している2つのシステムの半年ごとの統計によると、Nagiosは常にIcingaよりも速く動作し、本当にイライラしていました。 タイマーにだまされているものがあり、事実の5分間のチェックが5:30ごとなどに行われているように思えます。

- いつでもサービスを再起動する場合(systemctl restart icinga2)-その時点で進行中だったすべてのチェックは、画面上で重大な<信号で終了15>アラームをトリガーし、側面からすべてが落ちたように見えます( 確認済みのバグ )

しかし、一般的に-それは動作します。