数週間、コンピューターサイエンスの専門家であるSiwei Lyuは、苦痛を伴う懸念で彼のチームが作成したディープフェイクビデオを見ました。 機械学習アルゴリズムを使用して作成されたこれらの偽の映画は、有名人がやらないことをしていることを示しました。 彼らは、彼が彼らが偽物だと知っていたという理由だけでなく、彼にとって奇妙に恐ろしいように見えました。 「見た目が間違っている」と彼は考えを回想する。「しかし、この印象を正確に特定するのは非常に難しい。」

しかし、一度彼の脳の中に幼少期の記憶が生まれました。 他の多くの子供たちと同様に、彼は子供たちと「ピーパー」をしました。 「私はいつもそのような競争に負けていました」と彼は言います。「まばたきのない顔を見たとき、私は非常に不安を感じました。」

彼は、これらの偽の映画が彼に同様の不快感を引き起こしたことを理解しました。彼は、これらの映画スターに目を失いました。

理由を調べるために、アルバニー大学の教授であるLuyと彼のチームは、これらのビデオを作成したDeepFakeソフトウェアの各ステップを研究しました。

ディープフェイクプログラムでは、入り口にいる特定の人物(あなた、あなたの元恋人、金正恩)の多くの画像を撮影するため、さまざまな角度で、さまざまな表情の表情でそれらを見ることができます。 アルゴリズムは、このキャラクターがどのように見えるかを学習し、その人物が彼が決してしなかったことをどのように行うかを示すビデオで得た知識を合成します。 ポルノ ジョン・オリバーの言葉を話すスティーブン・コルバート 。 偽の動画の危険性について警告する大統領。

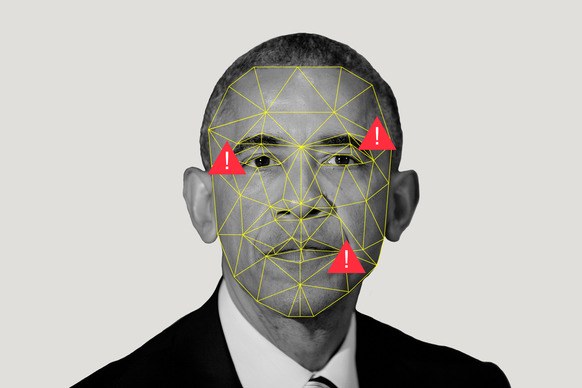

これらのビデオは、電話の画面では数秒間説得力がありますが、(まだ)完璧ではありません。 彼らは、例えば、奇妙な方法で、偽造の兆候を見ることができ、彼らの創造のプロセスの欠点から生じる目を常に開いています。 DeepFakeの根性を見ると、Luはプログラムが調査した画像の中で、目を閉じた写真はそれほど多くないことに気づきました(まばたきする自分撮りをしていないのですか?)。 「それは歪みになります」と彼は言います。 ニューラルネットワークはまばたきを理解しません。 プログラムは、他の「人間に固有の生理学的信号」を見逃す可能性もあります、とルヤは言いました。 この研究は特定のソフトウェアを使用して作成されたコマーシャルに焦点を当てていますが、写真の大きなセットでさえ、人の身体の知覚を適切に説明できない場合があるため、これらの画像で訓練されたソフトウェアは不完全です。

まばたきに関する啓示は、多くの偽のビデオを明らかにしました。 しかし、Luとチームが作業のドラフトをオンラインで投稿してから数週間後、YouTubeに投稿された次の偽の動画へのリンクを含む匿名の手紙を受け取りました。 偽造クリエイターは進化しました。

これは自然なことです。 ルーがカンバセーションのインタビューで述べたように、「目を閉じた画像をデータベースに含めるか、ビデオを使用してトレーニングすることで、ディープフェイクビデオに点滅を追加できます。」 偽のサインが何であるかを知っていれば、それを避けることができます-これは「単なる」技術的な問題です。 つまり、偽の動画はクリエイターとレコグナイザーの軍拡競争に巻き込まれることを意味します。 ルイの研究のような研究は、偽造メーカーの生活を複雑にするだけです。 「私たちは水準を引き上げようとしています」と彼は言います。 「このプロセスを複雑にし、より時間がかかるようにします。」

なぜなら今はとても簡単だからです。 プログラム、Googleの有名人の写真をダウンロードし、プログラムの入り口にフィードします。 彼女はそれらを消化し、それらから学びます。 そして、彼女はまだ完全に独立しているわけではありませんが、少しの助けを借りて、新しくて非常にリアルな何かを生み、産みます。

「彼女は非常にぼやけています」とLu氏は言います。 そして、彼はイメージを意味しません。 「この線は真実と偽物の間にある」と彼は明言する。

これは同時にイライラし、最近生きていてインターネットを閲覧している人を驚かせません。 しかし、これは軍とand報部にとって特に心配です。 特に、Luyaの研究は、他のいくつかの作品と同様に、MediFor-Media Forensicsと呼ばれるDARPAプログラムによって資金提供されています。

MediForプロジェクトは、代理店が偽造製造業者の活動の増加に気付いた2016年に開始されました。 このプロジェクトは、偽の兆候の3つのレベルを調査し、画像またはビデオの「現実の評価」を生成する自動システムを作成しようとしています。 最初のレベルでは、特定のモデルのカメラからのノイズや圧縮アーチファクトなど、汚れたデジタルトラックが検索されます。 2番目のレベルは物理的です:照明は顔にはありません。反射は、このランプの配置ではどのように見えるかは見えません。 後者はセマンティックです:確認された実際の情報とデータを比較します。 たとえば、サッカーの試合を撮影したビデオが2018年10月9日火曜日の午後2時にセントラルパークで撮影されたと言われている場合、空の状態は気象アーカイブと一致しますか? すべてのレベルを収集し、データの現実の評価を取得します。 DARPAは、MediForの終わりまでに、大規模なチェックを手配できるシステムのプロトタイプがあることを望んでいます。

しかし、時計は刻々と過ぎています(または、時間追跡に関連するデータでトレーニングされたAIによって作成された繰り返し音ですか?)「数年後には、イベントの製作などに出くわすことができます」と、DARPAプログラムマネージャーMatt Turekは言います。 「1つの画像や編集されたビデオだけでなく、説得力のあるメッセージを伝えようとする複数の画像やクリップ。」

コンピューター科学者のジャストン・ムーアは、ロスアラモス国立研究所の将来の可能性をより明確に把握しています。 たとえば、ムーアが薬局を略奪するビデオが必要であることをアルゴリズムに通知します。 この機関のセキュリティシステムのビデオ録画で紹介しています。 彼を刑務所に送ります。 言い換えれば、証拠を検証するための基準が偽物の製造と並行して開発されない(またはできない)場合、人々を代用するのは簡単だろうと心配しています。 そして、裁判所が視覚データに頼ることができない場合、実際の証拠が無視されることが判明する可能性があります。

私たちは、一度見ることは百回聞くことよりも良くないという論理的な結論に達します。 「写真の証拠を信用しないことが起こるかもしれません」と彼は言います、「そして、私はそのような世界に住みたくありません。」

そのような世界はそれほど素晴らしいものではありません。 そして、ムーアによると、問題は顔の置き換えをはるかに超えています。 「アルゴリズムは、実在の人物に属さない人々の画像を作成でき、奇妙なことに画像を変更し、 馬をシマウマに変えることができます」とムーアは言います。 画像の一部を削除し、ビデオから前景オブジェクトを削除できます。

偽造品が処理されるよりも早く処理できないかもしれません。 しかし、うまくいくかもしれません。この機会は、ムーアのチームが証拠を研究するためのデジタル手法を研究する動機付けとなります。 サイバーシステム、情報システム、理論生物学、生物物理学の知識を組み合わせたLos Alamosプログラムは、DARPA機関よりも1年ほど若いです。 画像に含まれている情報が見かけほど多くない場合、1つのアプローチは「圧縮性」に焦点を合わせます。 「基本的に、すべてのAIイメージジェネレーターには、作成できるものが限られているという考えに基づいています」とムーアは言います。 「だから、私やあなたにとってイメージがかなり複雑に見える場合でも、その中に繰り返し構造を見つけることができます。」 ピクセルを再処理するとき、あまり残っていません。

また、スパースコーディングアルゴリズムを使用して、対戦でゲームをプレイします。 2つのコレクションがあるとしましょう:実画像の束と人工的に作成されたAI画像の束。 アルゴリズムはそれらを研究し、ムーアが「視覚要素の辞書」と呼ぶものを作成します。人工画像には共通点があり、実際の画像には共通点があることに注意してください。 ムーアの友人がオバマの画像をリツイートし、ムーアがその画像がAIを使用して作成されたと考えた場合、彼はそれをプログラムで実行し、どの辞書に近いかを見つけることができます。

世界で最も強力なスーパーコンピューターの1つであるロスアラモスは、誰かが偽の強盗を介してムーアを代替できるという理由だけでなく、このプログラムにリソースをアップロードします。 研究所の使命は、「科学的卓越性を活用して国家安全保障の問題を解決する」ことです。 彼らの主な任務は、核の安全性であり、爆弾が爆発すべきでないときに爆発せず、爆発すべきなときに爆発する(そうしないでください)ことを保証するとともに、不拡散の支援を提供します。 これにはすべて、機械学習の一般的な知識が必要です。これは、ムーアが言うように、「小さなデータセットから大きな結論を引き出す」のに役立つからです。

しかし、これに加えて、ロスアラモスのような企業は、自分の目を信じることができるはずです。 なぜなら、国がどのように核兵器を動員またはテストするかについての衛星画像を見たらどうでしょうか? 誰かがセンサーの読み取り値を偽造した場合はどうなりますか?

これは恐ろしい未来であり、ムーアとルーの仕事は理想的には避けるべきです。 しかし、すべてが失われた世界では、見ることは信じることを意味しませんが、一見絶対的な測定値は偽物である可能性があります。 デジタルはすべて疑わしい。

しかし、「疑念」は間違った言葉かもしれません。 多くの人は額面で偽物を取ります(ヒューストンのサメの写真を覚えていますか?)、特にコンテンツが彼らの信念と一致する場合。 「人々は彼らが信じがちなことを信じます」とムーアは言います。

この可能性は、国家安全保障の分野よりもニュースを見ている一般大衆の方が高い。 そして、私たちの間で誤った情報が拡散するのを防ぐために、DARPAは、金正恩がマカロンを踊るビデオの信頼性がかなり低いとユーザーが判断できるように、ソーシャルメディアコラボレーションを提供しています。 Turekは、ソーシャルネットワークは、ビデオ自体に反して、ビデオに反論するストーリーを広めることができると指摘しています。

しかし、彼らはそれをしますか? 暴露は面倒なプロセスです(噂ほど効率的ではありませんが)。 そして、人々は、フィクションについて考えを変える前に、事実を実際に示す必要があります。

しかし、誰もがビデオの真実性について大衆の意見を変えることができないとしても、政治的および法的決定を下す人々-ロケットを輸送しているのか、人々を殺しているのか-は、AIの夢から明確な現実を分離するために機械を使用しようとすることが重要です。