みなさんこんにちは。 視聴者をすぐに2つの部分に分けます。ビデオを見るのが好きな人と、私のようにテキストをよりよく知覚する人です。 最初を苦しめないために、Data-Treeでの私のスピーチの記録:

すべての主要なポイントがありますが、プレゼンテーション形式は記事の詳細な調査を意味しません。 リンクと詳細な分析の愛好家、猫へようこそ。

最後に、この場所を読んだ人は、以下で書かれたものはすべて法廷で彼らに対して使用できることを知ることができるのは私の見解であり、他の人の視点は私のものとは異なる場合があります。

トレンド

2017年、私たちの分野(自然言語処理、NLP)の開発で、2つの主な傾向を挙げました。

- 加速と並列化 -すべてのモデルは、並列性の向上を含め、加速しようとします。

- 教師なしで学習- 教師なしで学習するアプローチは、マシンビジョンでは長い間人気がありましたが、NLPでは比較的まれです(これらのアイデアの使用のまれではあるが鮮やかな例はword2vecです)。 今年、そのようなアプローチの使用は非常に人気があります。

次に、今年の主要なアイデアをより詳細に分析します。

必要なのは注意だけです

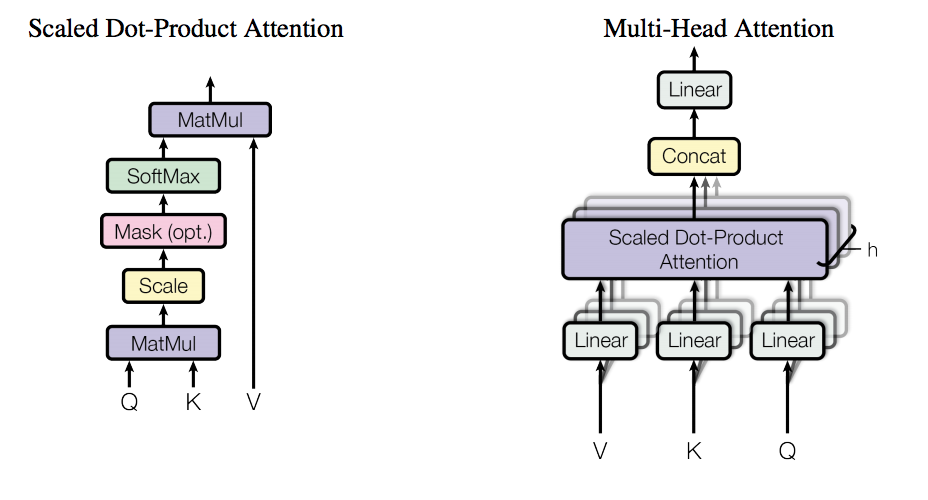

このすでによく知られている作業により、完全に接続されたネットワークがNLPドメインに再登場します。 著者はGoogleの従業員です(ちなみに、著者の1人であるIlya PolosukhinがDeepHack.Babel hackathonで講演します)。 Transformerアーキテクチャの基盤となるアイデア(まさに図に示されているもの)は、すべて独創的であるようにシンプルです。繰り返しなどすべてを忘れて、結果を達成するために注意を払いましょう。

しかし、最初に、現在のすべての高度な機械翻訳システムがリカレントネットワークで機能することを思い出しましょう。 直感的にリカレントなニューラルネットワークは、プロセスで使用されるアーキテクチャに明示的なメモリが組み込まれているため、機械翻訳などの自然言語処理タスクに完全に適している必要があります。 このアーキテクチャ上の特徴には明らかな利点がありますが、密接に関連する欠点もあります。データを処理するためにメモリを使用するため、特定の順序でのみ処理できます。 その結果、完全なデータ処理には長時間かかる場合があります(たとえば、CNNと比較して)。 そして、これはまさに作品の作者が戦いたかったことです。

そしてここに、Transformerがあります-機械翻訳のためのアーキテクチャで、再発はありません。 そして、すべての作業を行うだけの注意。

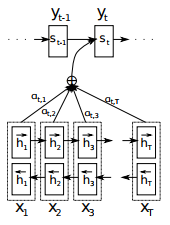

最初に、Dmitry Bogdanov(Dzmitry Bahdanau)によって提案された標準的な注意のアプローチがどのようなものかを思い出しましょう。

アテンションメカニズムの考え方は、より良いデコードを実行するために、エンコーダーへの関連する入力に焦点を当てる必要があるということです。 最も単純な場合、関連性は、各入力と現在の出力との類似性として定義されます。 この類似性は、重みのある入力の合計として順番に定義されます。重みは1に合計され、最大の重みは最も関連性の高い入力に対応します。

上の図は、Dmitry Bogdanovによるオーサーシップの古典的なアプローチを示しています。1つの入力セット-エンコーダーの隠れ状態(h)、およびこれらの入力の係数セット(a)があります。 これらの係数は、潜在状態以外の入力に基づいて毎回計算されます。

古典的なアプローチとは対照的に、この研究の著者は、入力データに対するいわゆる自己注意を提案しました。 この場合の「自己」という言葉は、それが計算される同じデータに注意が適用されることを意味します。 同時に、古典的なアプローチでは、注意は、それが適用されるデータに関連する追加の入力によって計算されます。

さらに、この自己注意はマルチヘッドと呼ばれます。 1つの操作を並行して数回実行します。 この機能は、次のように畳み込みフィルターに似ている場合があります。 各「ヘッド」は、入力シーケンスの異なる場所を調べます。 もう1つの重要な機能は、このバリアントでは、標準のアプローチのように2つではなく3つのエンティティが入力を考慮することです。 上の図でわかるように、入力Q(クエリ)とK(キー)で「サブアテンション」が最初に計算され、次にサブアテンションの出力が入力のV(値)と結合されます。 この機能は、記憶の概念を示しており、さまざまなものが注意のメカニズムです。

最も重要なことに加えて、さらに2つの重要な機能があります。

- 位置エンコード 、

- デコーダーのマスクされた注意( マスクされた注意 )。

位置エンコード -思い出すように、モデルのアーキテクチャ全体は完全に接続されたネットワークであるため、ネットワーク内のシーケンスの概念は確立されていません。 シーケンスの存在に関する知識を追加するために、位置エンコードが提案されています。 私に関しては、位置エンコードを作成する三角関数(sinとcos)の使用は完全に自明ではない選択のようですが、それは機能します:単語ベクトルと組み合わせた位置エンコードベクトル(たとえば、上記のword2vec)は、単語の意味についての知識を提供しますおよびネットワーク内での相対的な位置。

マスクされたアテンションはシンプルですが重要な機能です。繰り返しますが、 ネットワークにはシーケンスの概念はありません。デコード中に利用できない次の単語に関するネットワークのアイデアを何らかの方法で除外する必要があります。 そのため、写真でわかるように、ネットワークがまだ見るべきではない単語を「閉じる」マスクを挿入します。

これらのすべての機能により、ネットワークは機能するだけでなく、機械翻訳の現在の結果を改善することもできます。

ニューラル機械翻訳用の並列デコーダー

説明されている最後のアーキテクチャ機能は、 次の作品の著者には適さなかった、グループの従業員であるSalesforce ResearchのRichard Socher(ちなみに、従業員の1人である要約に関する別の有名な作品の著者であるRomain Paulusも、DeepHack hackathonで出演します) .Babel )。 デコーダーに対するマスクされた注意は、高速パラレルエンコーダーに比べて十分な速さではなかったため、次のステップに進むことにしました。「パラレルエンコーダーがある場合、パラレルデコーダーを作成しないのはなぜですか?」 これは私の仮定ですが、この作品の著者が頭の中で同様の考えを持っていたことを保証する準備ができています。 そして、彼らは計画を実行する方法を見つけました。

彼らはそれを非自己回帰トランスコーディング、非自己回帰トランスフォーマー全体のアーキテクチャと呼びました。つまり、復号時に他の単語に依存する単語はありません。 これは多少誇張されていますが、それほど大きくはありません。 ここでのエンコーダーは、各入力語のいわゆる出生率をさらに表示するという考え方です。 このレベルの受胎能力は、単語自体のみに基づいて、各単語の実際の翻訳を生成するために使用されます。 これは、機械翻訳の標準的なマッチングマトリックス(アライメントマトリックス)の一種として見ることができます。

ご覧のとおり、いくつかの単語は複数の単語に対応しており、一部は別の言語の特定の単語に対応していません。 したがって、出生率はこのマトリックスを断片に単純にスライスします。各断片はソース言語の特定の単語を参照します。

したがって、私たちは生殖能力レベルを持っていますが、これは完全な並列デコードには十分ではありません。 位置の注意(位置のエンコードに対応する)と相互の注意(元の作品のマスクされた注意を置き換える)のいくつかの追加の注意レベルを写真で見ることができます。

残念ながら、速度が大幅に向上する場合があります(場合によっては8倍)。非自己回帰デコーダーは、BLEUのいくつかのユニットの品質をオリジナルよりも低下させます。 しかし、これは改善する方法を探す機会です!

教師なし機械翻訳

記事の次の部分は、数年前には不可能と思われていたタスク、つまり教師なしで訓練された機械翻訳に専念しています。 私たちが議論する作品:

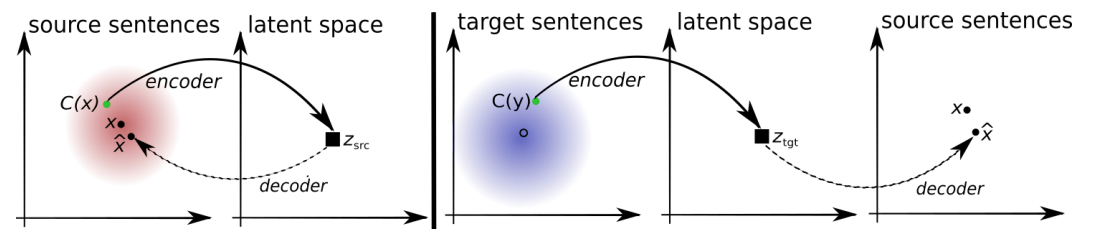

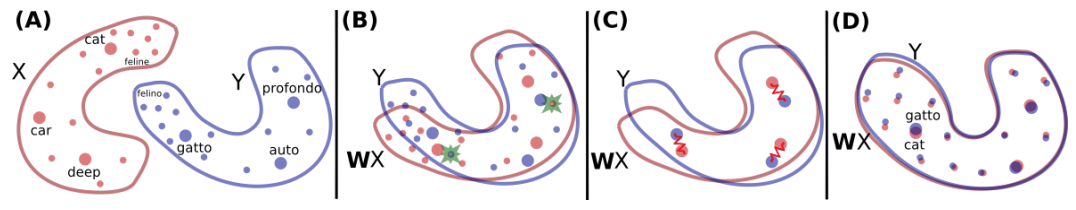

名前から判断して、最後の作品はこのシリーズでは不必要ですが、彼らが言うように、第一印象は誤解を招きます。 3つの作品はすべて、基本的な考え方が共通しています。 簡単に言うと、2つの異なるテキストソース(たとえば、異なる言語、または異なるスタイルのテキスト)の2つの自動エンコーダーがあり、これらの自動エンコーダーのデコード部分を交換するだけです。 どのように機能しますか? それを理解してみましょう。

自動エンコーダー(上の図の左側)は、デコーダーが元のスペースにデコードするエンコーダーデコーダーです。 これは、入り口と出口が同じ言語(またはスタイル)に属することを意味します。 したがって、テキストがいくつかあり、デコーダーが元の文を再構築できるように、このテキストのベクトル表現を作成するようにエンコーダーをトレーニングします。 理想的には、再構築された文はまったく同じになるでしょう。 しかし、ほとんどの場合、これは事実ではなく、元の文と再構成された文の類似性を何らかの方法で測定する必要があります。 そして機械翻訳のために、そのような手段が考案されました。 これは、現在BLEUと呼ばれている標準的なメトリックです。

- BLEU-このメトリックは、特定の翻訳と事前に既知の参照翻訳との間で重複する単語とn-gram(n個の連続した単語)の数を測定します。 BLUE-4と呼ばれる最も一般的に使用されるBLUEのバージョンは、2〜4の長さの単語とフレーズで動作します。さらに、短すぎる(参照に対して)翻訳にはペナルティが導入されます。

ご想像のとおり、このメトリックは微分可能ではないため、翻訳者をトレーニングするための別の方法が必要です。 自動エンコーダの場合、これは標準のクロスエントロピーかもしれませんが、これは翻訳には十分ではありません。 ここでは、これを省略して続行します。

OK、自動エンコーダーを作成する方法ができました。 次に行う必要があるのは、ソース言語(スタイル)用とターゲット言語用の2つのトレーニングです。 そして、ターゲット言語のデコーダーがソース言語のエンコードされた文字列を「回復」できるようにそれらを交差させる必要があります。逆の場合も同じです。

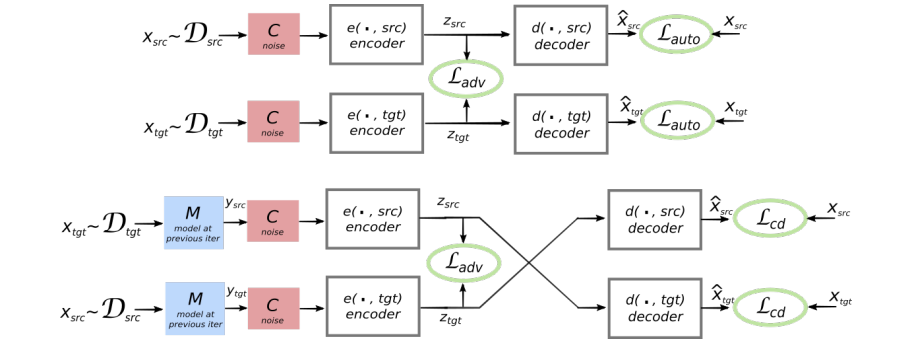

理解するのが最も困難になります。自動エンコーダー(または他のエンコーダーデコーダー)には、いわゆる隠し表現(高次元空間からのベクトル)があります。 2つの自動エンコーダーの互換性が必要な場合(必要な意味で)、非表示のビューが同じスペースにあることを確認する必要があります。 これを達成する方法は? これらの自動エンコーダに特別な罰金を追加することにより。 このペナルティは差別者によって課せられ、GANの概念を示しています。

- GAN-生成的敵対ネットワーク。 GANの概念は、「ネットワークはそれ自体で遊んで、自分自身を欺こうとする」と表現できます。 GANアーキテクチャでは、3つの主要なコンポーネントが区別されます。 ジェネレーター -実際の表現にできるだけ近い表現を生成します。GoldenSource-実際の表現を提供し、 判別子 -入力が生成元または生成元から区別される必要があります。 識別器が推測できる場合、ジェネレータはペナルティを受けます。 しかし、その逆も真です-彼が推測できない場合、弁別器は処罰されます。 したがって、彼らは彼ら自身の競争で一緒に訓練します。

私たちの場合、ディスクリミネーター(図のL_adv)は、ソース言語またはターゲット言語からの入力がどこから来たかを示す必要があります。 上の写真は、別々のブロックの形式の2つの自動エンコーダー(エンコーダーとデコーダー)を示しています。 それらの間の中央には、識別器が配置されている接続があります。 このような追加のペナルティで2つのオートコーダーをトレーニングすることにより、モデルに両方のオートコーダーの隠された表現を類似させる(画像の上部)ようにし、すべてが明確になります-元のデコーダーを別のオートコーディング(画像の下部)からのアナログに置き換え、翻訳する!

このセクションで言及されている3つの作品はすべて、もちろん独自の特性を備えたこのアイデアを基礎にしています。 上記の説明は主に、 Monolingual Corpora Onlyを使用した教師なし機械翻訳の作業に基づいているため、特にその結果が上記の作業で使用されているため、これらの著者の以前の作業に言及する必要があります。

この作品のアイデアは、すべての独創的なのと同じくらい簡単です:

2つの異なる言語の単語のベクトル表現があるとします。 (たとえば、ニュースやフィクションなど、同じドメインのテキストを使用するとします。)これらの言語の辞書は非常に近いと合理的に仮定できます。ソースコーパスのほとんどの単語について、ターゲットコーパスの単語に一致するものを見つけることができます-たとえば、概念、社長、エコロジー、税金を表す単語は、両方の言語でニュースビルにある可能性があります。 では、なぜそのような単語を互いに接続し、あるベクトル空間を別のベクトル空間に引っ張らないのですか? 実際、彼らはそうしました。 ベクトル空間を変換し、あるポイント(単語)を別のポイントに重ね合わせる関数を見つけました。 この研究では、著者はこれが教師なしでできることを示しました。つまり、辞書自体は必要ないということです。

クロスアラインメントによる非平行テキストからのスタイル転送の作業は、このセクションに配置されています。 言語はさまざまなスタイルのテキストと見なすことができ、著者自身が作品の中でこれについて言及しています。 この作品も面白いです 実装は利用可能です。

制御可能なテキスト生成

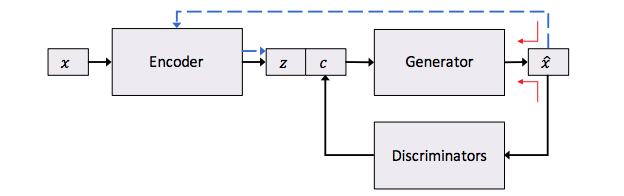

このセクションは前のセクションと精神的に近いですが、それでもかなり異なります。 ここで検討される作品:

最初の作品は、制御された生成に近い、テキストのスタイルの転送における異なるアプローチを提示するため、この作品は前のものとは異なり、ここに配置されます。 制御された生成の概念は、次の図で説明できます。

ここでもテキストの自動エンコーダーが表示されますが、機能があります:隠されたビュー(ここでの意味に責任があります)には特別な機能が追加されています。 これらの文字は、調性や文法時間など、テキストの特定のプロパティをエンコードします。

また、自動エンコーダーに加えて、写真に弁別器を見ることができます。 より具体的なプロパティをコーディングする場合は、複数のディスクリミネーターが存在する場合があります。 その結果、複雑な損失関数があります-自動エンコーダーからの再構築損失と、特定のテキストプロパティに対する追加のペナルティー。 したがって、ここでの再建損失は、他の特性を伴わずに、提案の意味に対して単独で排他的に責任を負います。

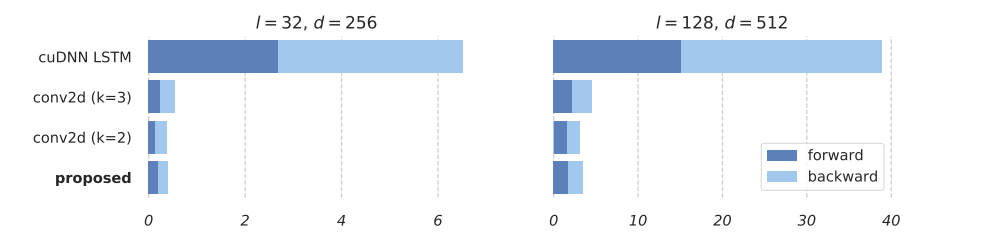

シンプルな繰り返しユニット

最後になりましたが、重要なセクションです。 また、計算速度にも焦点を当てています。 記事の冒頭で、完全に接続されたネットワークの復帰という形でのファンダメンタルズのショックについて説明しましたが、それにもかかわらず、NLPのすべての最新システムはリカレントネットワークで動作します。 そして、誰もがRNNがCNNよりもはるかに遅いことを知っています。 かどうか? この質問に答えるために、次の記事を見てみましょう。

この作品の作者は質問に答えようとしたと思います:なぜRNNはそんなに遅いのですか? 何がそうですか? そして、彼らはソリューションの鍵を見つけました。RNNは本質的に一貫しています。 しかし、この一貫した性質の小さな部分だけを残して、残りを並行して行うことができたらどうでしょうか? (ほぼ)すべてが以前の状態から独立していると仮定しましょう。 その後、入力シーケンス全体を並列処理できます。 したがって、タスクは、以前の状態から不要な依存関係をすべて破棄することです。 そして、これはそれがもたらしたものです:

ご覧のとおり、最後の2つの方程式のみが以前の状態に依存しています。 そして、これらの2つの方程式では、行列ではなくベクトルを使用します。 そして、重い計算はすべて独立して並行して実行できます。 そして、数回の乗算を行ってデータを順次処理します。 この制作は素晴らしい結果を示しました。

Simple Recurrent Unit(SRU)の速度は、CNNとほぼ同じです!

おわりに

2017年、トランスフォーマーなどの新しい強力なプレイヤーが私たちの地域に登場し、教師なしで働く機械翻訳のようなブレークスルーが行われましたが、老人たちはあきらめません-SRUはまだこの戦いでRNNの名誉のために立ち上がっています。 だから私は2018年に新しいブレークスルーを期待して見ていますが、それはまだ想像できません。