より多くのGPUを構築する必要がある

ディープラーニングは、機械学習の分野で最も集中的に開発されている分野の1つです。 ディープ(ディープ)学習の分野での研究が成功すると、これらのアルゴリズムを実装するML / DLフレームワーク(Google、Microsoft、Facebookのものを含む)の数が増加します。 DLアルゴリズムの計算がますます複雑になり、その結果、DLフレームワークがますます複雑になっているため、デスクトップやサーバーCPUのハードウェア容量は長い間乗っ取られていません。

彼らは解決策を見つけましたが、このタイプの計算集約的なタスクにGPU / FPGA計算を使用するのは簡単です(このようです)。 しかし、ここに問題があります。もちろん、これらの目的でお気に入りのラップトップのグラフィックカードを使用できますが、

高性能GPUを所有するには、購入( オンプレミス )とレンタル( オンデマンド )の少なくとも2つのアプローチがあります。 保存して購入する方法は、この記事のトピックではありません。 これでは、クラウドプロバイダーのAmazon Web ServiceとWindows Azureの高性能GPUを備えたVMインスタンスをレンタルするためのオファーを検討します。

1. AzureのGPU

2016年8月上旬、NVidia Teslaカードを搭載した仮想マシンインスタンスのプライベートプレビューが発表されたことが発表されました[1]。 この機能は、 Azure VMサービスの一部として提供されます 。AzureVMサービスは、オンデマンドで仮想マシンを提供するIaaSサービスです( Amazon EC2と同様)。

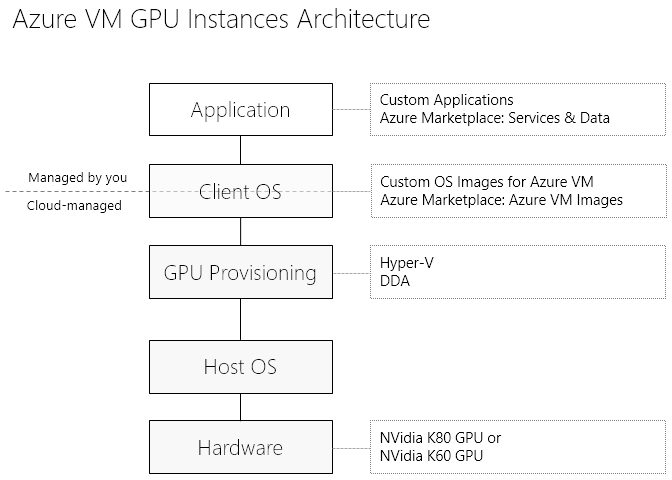

GPUへのアプリケーションアクセスの観点から見ると、サービスアーキテクチャは次のようになります。

GPU計算は、Nシリーズの仮想マシンで利用できます。これは、次の2つのカテゴリに分類されます。

- NCシリーズ ( コンピューター中心 ):コンピューティングを目的としたGPU。

- NVシリーズ ( 視覚化重視 ):グラフィックコンピューティングを目的としたGPU。

1.1。 NCシリーズVM

CUDA / OpenCLを使用して、計算集中型のワークロード向けに設計されたGPU。 それらのグラフィックスカードは、NVidia Tesla K80:4992 CUDAコア、> 2.91 / 8.93 Tflops(倍精度/単精度)です。 カードへのアクセスは、DDAテクノロジー(個別のデバイス割り当て)を使用して実行されます。DDAテクノロジーは、VMを介して使用する場合のGPUパフォーマンスをカードのベアメタルパフォーマンスに近づけます。

ご想像のとおり、NCシリーズVMはML / DLタスク用に設計されています。

Tesla K80を搭載した次のVM構成は、Azureで利用できます。

| NC6

| NC12

| NC24

| |

| コア

| 6(E5-2690v3)

| 12(E5-2690v3)

| 24(E5-2690v3)

|

| GPU

| 1 x K80 GPU(1/2物理カード)

| 2 x K80 GPU(1物理カード)

| 4 x K80 GPU(2枚の物理カード)

|

| 記憶

| 56 GB

| 112 GB

| 224 GB

|

| ディスク

| 380 GB SSD

| 680 GB SSD

| 1.44 TB SSD |

1.2。 NVシリーズVM

NVシリーズの仮想マシンは、視覚化のために設計されています。 これらのVMには、Tesla M60 GPU(4086 CUDAコア、1080p H.264上の36ストリーム)があります。 これらのカードは、(デ)コーディング、レンダリング、3Dモデリングタスクに適しています。

次の構成でVMインスタンスの可用性を主張しました。

| NV6

| NV12

| NV24

| |

| コア

| 6(E5-2690v3)

| 12(E5-2690v3)

| 24(E5-2690v3)

|

| GPU

| 1 x M60 GPU(1/2物理カード)

| 2 x M60 GPU(1物理カード)

| 4 x M60 GPU(2枚の物理カード)

|

| 記憶

| 56 GB

| 112 GB

| 224 GB

|

| ディスク

| 380 GB SSD

| 680 GB SSD

| 1.44 TB SSD |

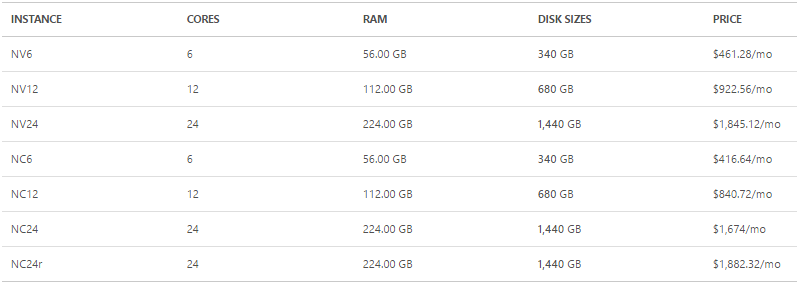

1.3。 価格

NシリーズAzure VMの価格は次のとおりです(2016年10月)[5]。

ただし、これらの4桁の数字で好奇心を減らさないでください。いつものように、クラウドではリソースの使用に対して支払います。 IaaSサービスの場合、Azure VMサービスとは何か、1時間ごとの課金として理解する価値があります。 さらに、Microsoft Azureには多くの方法があります 金 コンピューティングリソースは完全に無料です。

これは、Azureの新しいアカウント、学生、スタートアップに適用されます。 がんの治療法を探している 研究者、またはあなた/あなたが働いている会社がMSDNサブスクリプションの所有者である場合。

2. Amazon EC2 GPUインスタンス(+危険な比較)

クラウドプロバイダーであるAmazon Web Services(AWS)は、2010年にVMにGPUを提供し始めました。

2016年9月初旬に、AWS GPUはG2ファミリーのみで代表されていました。

G2ファミリの仮想マシン構成:

| モデル | GPU | vCPU | Mem(GiB) | SSDストレージ(GB) | 1時間あたりの価格/月 |

| g2.2xlarge | 1 | 8 | 15 | 1 x 60 | 0.65 / 468 |

| g2.8xlarge | 4 | 32 | 60 | 2 x 120 | 2.6 / 1872 |

G2インスタンスには、1556 CUDAコアを備えたNVidia GRID K520 GPUが装備され、4つのex 1080p H.264ビデオストリームをサポートします。 CUDA / OpenCLのサポートを発表しました。 また、HVMテクノロジー(ハードウェア仮想マシン)のサポートもあります。これは、Azure VMのDDAと同様に、仮想化に関連するコストを最小限に抑え、ゲストVMがGPUのパフォーマンスをベアメタルパフォーマンスに近づけることを可能にします。

記事を書いている間に ほんの1か月前(2016年9月末)、AWSはより新しいグラフィックスカードを含むP2インスタンスを発表しました。

P2ファミリのインスタンスには、最大8枚のNVIDIA Tesla K80カードを含めることができます。 CUDA 7.5、OpenCL 1.2のサポートを発表しました。 p2.8xlargeおよびp2.16xlargeインスタンスは、高速GPUからGPUへの接続をサポートし、ENAテクノロジー(Elastic Network Adapter-Amazon EC2の高速ネットワークインターフェイス)を使用した最大20 Gbpsがローカルネットワークで利用可能です。

| インスタンス名 | GPUコア | vCPUコア | メモリGB | Cudaコア | GPUメモリ | ネットワーク、Gbps |

| p2.xlarge | 1 | 4 | 61 | 2496 | 12 | 高い |

| p2.8xlarge | 8 | 32 | 488 | 19968 | 96 | 10 |

| p2.16xlarge | 16 | 64 | 732 | 39936 | 192 | 20 |

比較のために、Azure VMで最も生産性の高い(NC24)および最も予算の高い(NC6)インスタンスを使用し、Amazon EC2でAzure VMインスタンスに最も近いパフォーマンスを使用します。

| インスタンスファミリー | GPUモデル | GPUコア | vCPUコア | RAM、Gb | ネットワーク、Gbps | CUDA / OpenCL | ステータス | 価格、$ /月 | 価格、GPU /月あたりの価格 |

| Amazon p2.xlarge | K80 | 1 | 4 | 61 | 高い | 7.5 / 1.2 | GA | 648 | 648 |

| Azure NC6 | K80 | 1 | 6 | 56 | 10(?) | + / + | プライベートプレビュー | 461 | 461 |

| Amazon p2.8xlarge | K80 | 8 | 32 | 488 | 10 | 7.5 / 1.2 | GA | 5184 | 648 |

| Azure NC24 | K80 | 8 | 24 | 224 | 10(?) | + / + | プライベートプレビュー | 1882 | 235 |

おわりに

AWSは長い間、データサイエンスコミュニティをかなり弱くし、同時に高価なG2ファミリのGPUインスタンスを「苦しめ」ました。 しかし、クラウドプロバイダー市場での競争はその役割を果たしました。1か月前、P2ファミリのGPUインスタンスが登場し、非常に価値があります。

Microsoft Azureは、GPUインスタンスが不足しているため、コミュニティから長い間苦しめられてきました(これは、Azureプラットフォームで最も期待されていた機能の1つでした)。 現在、Azure GPUは技術的な詳細を欠いていますが、かなり見栄えが良いです。 この機能のプレビューステータスは

一般的に、Microsoftは1〜2年で文字通り、開発者やデータサイエンティスト向けの(おそらく最初の)さまざまなAIテクノロジー/フレームワーク/ツールで深刻に成長しました。 9月下旬に開催されたMicrosoft ML&DS Summitの記録を見ると、これらすべてを自分で評価することができます[6]。

さらに、ちょうど1週間後(11月1日)にMicrosoft DevCon Schoolカンファレンスが開催され、そのコースの1つは完全に機械学習に専念しています。 また、プロプライエタリなMSテクノロジーだけでなく、おなじみの「無料」のPython、R、Apache Sparkについても話します。

ソースのリスト

- AzureのNVIDIA GPU :プレビュープログラムへの登録。

- AzureでのNVIDIA GPUの活用 。 チャンネル9でのウェブキャスト。

- Linux GPUインスタンス :ドキュメント。

- AWSでのP2インスタンスの発表 、2016年9月29日。

- Azure Virtual Machines (Azure VM GPUを含む)の価格 。

- Microsoft Machine Learning&Data Science Summit Conference。