私たちのブログでは、我々は、作成に関する多くの書き込み、電子メール、郵送をして電子メールを使用します。 現代の世界では、人々は多くの手紙を受け取り、完全に成長する中で、メールボックスの分類と構成に問題があります。 米国のエンジニアAndrei Kurenkovがブログで、ニューラルネットワークを使用してこの問題をどのように解決したかについて語っています。 このプロジェクトの進捗状況を強調することにしました-数日前、ストーリーの最初の部分を公開し、今日はその継続を紹介します。

ディープラーニングはここでは適していません

Kurenkovが最初にKerasコードの研究を始めたとき、彼は(間違って)テキストの実際の語順を反映したシーケンスを使用すると思いました。 これはそうではないことが判明しましたが、これはそのようなオプションが不可能であることを意味しません。 機械学習の分野で本当に注目に値するのは、リカレントニューラルネットワークであり、大量のデータを扱うのに最適です、と著者は書いています。 このアプローチは、単語を扱う場合、「準備」ステップが実行され、各単語が数値ベクトルに変換され、類似した単語が類似したベクトルになるようにすることを意味します。

これにより、文字をバイナリ記号のマトリックスに変換する代わりに、文字の出現頻度を使用して単語を数字に置き換え、数字自体を各単語の「意味」を反映するベクトルに置き換えることができます。 次に、結果のシーケンスを使用して、Long Short Term MemoryやGated Recurrentなどのリカレントニューラルネットワークをトレーニングすることができます。 そして、このアプローチは既に実装されています :例を実行して、何が起こるかを見ることができます:

エポック1/15 7264/7264 [=================================]-1330年代-損失:2.3454-acc:0.2411-val_loss:2.0348-val_acc:0.3594 エポック2/15 7264/7264 [=================================]-1333s-損失:1.9242-acc:0.4062-val_loss:1.5605-val_acc:0.5502 エポック3/15 7264/7264 [=================================]-1337s-損失:1.3903-acc:0.6039-val_loss:1.1995-val_acc:0.6568 ... エポック14/15 7264/7264 [==================================]-1350s-損失:0.3547-acc:0.9031-val_loss:0.8497-val_acc:0.7980 エポック15/15 7264/7264 [=================================]-1352s-損失:0.3190-acc:0.9126-val_loss:0.8617-val_acc:0.7869 テストスコア:0.861739277323

精度:0.786864931846

学習には永遠に時間がかかりましたが、結果はそれほど良くありませんでした。 おそらく、その理由はデータがほとんどなく、シーケンス全体がそれらを分類するのに十分効果的ではなかったためかもしれません。 これは、シーケンスの学習の複雑さが増加しても、テキストの単語を正しい順序で処理する利点が得られないことを意味します(ただし、送信者とレターの特定の単語は、どのカテゴリに属しているかをよく示しています)。

しかし、追加の「準備」ステップは、単語のより広い表現を作成したため、エンジニアにとっては依然として有用であると思われました。 したがって、彼はそれを試してみる価値があると考え、重要な局所標識を検索するために畳み込みを接続しました。 また、準備段階を実行すると同時に、結果のベクトルをLSTM層ではなく畳み込み層とサブサンプリング層に転送するKerasの例が見つかりました。 しかし、結果は再び印象的ではありません:

エポック1/3 5849/5849 [==================================]-127s-損失:1.3299-acc:0.5403-val_loss:0.8268-val_acc:0.7492 エポック2/3 5849/5849 [==================================]-127s-損失:0.4977-acc:0.8470-val_loss:0.6076-val_acc:0.8415 エポック3/3 5849/5849 [=================================]-127s-損失:0.1520-acc:0.9571-val_loss:0.6473-val_acc:0.8554 テストスコア:0.556200767488

精度:0.858725761773

理論的にはシーケンスには文字自体に関する情報がより多く含まれているため、エンジニアはシーケンスと準備ステップを使用した学習がN-gramモデルよりも優れていることを本当に望んでいました。 しかし、ディープラーニングは小さなデータセットに対してあまり効果的ではないという一般的な信念は公平であることが判明しました。

すべての兆候のため、ばか

したがって、実行されたテストでは90%の精度は得られませんでした。ご覧のとおり、最も一般的な2500の単語から属性を決定する現在のアプローチは適切ではありません。 「宿題」のタイプ。 しかし、人気のある単語を削除したり、いくつかの単語セットを拒否したりすることは危険です-おそらく、私はこの単語またはその「単純な」単語を他のカテゴリよりも頻繁に使用するため、「個人」セクション)。

ここでは、占いから機能選択方法を使用して、本当に良い単語を選択し、機能しない単語を除外する必要があります。 このためには、scikitとそのSelectKBestクラスを使用するのが最も簡単です。これは非常に高速であるため、ニューラルネットワークの操作に比べて選択に最小限の時間がかかります。 だから、これは役立ちますか?

処理される単語の数に対するテストの精度の依存性:

うまくいきます-90%!

いいね! 全体的なパフォーマンスにはわずかな違いがありますが、より大きな単語のセットから始める方が明らかに優れています。 ただし、このセットは機能を選択することで大幅に削減でき、パフォーマンスを損なうことはありません。 どうやら、このニューラルネットワークは再トレーニングに問題はありません。 プログラムによる「最良および最悪」の単語の検査により、十分に定義されていることが確認されます。

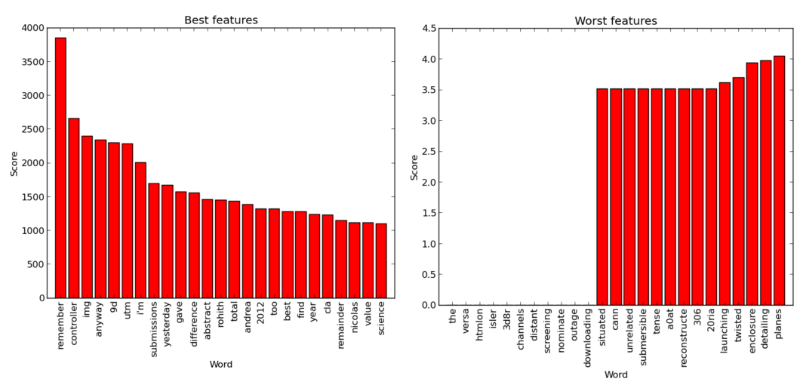

「最良」および「最悪」の単語:カイ2乗基準を使用した属性の選択(scikitの例のコードに基づく)

多くの「良い」単語は、予想されるように、名前または特定の用語(たとえば、「コントローラー」)ですが、Kurenkovは、「remember」や「total」などの単語を選択しないと述べています。 一方、「最悪」の単語は、一般的すぎるか、まれすぎるため、かなり予測可能です。

要約すると、単語が多いほど、機能が優れており、機能を選択することで仕事が速くなります。 それは役立ちますが、テスト結果をさらに増やす方法があるかもしれません。 見つけるために、エンジニアは、 scikit learnから取得したエラーマトリックスを使用して、ニューラルネットワークがどのエラーを引き起こすかを調べることにしました 。

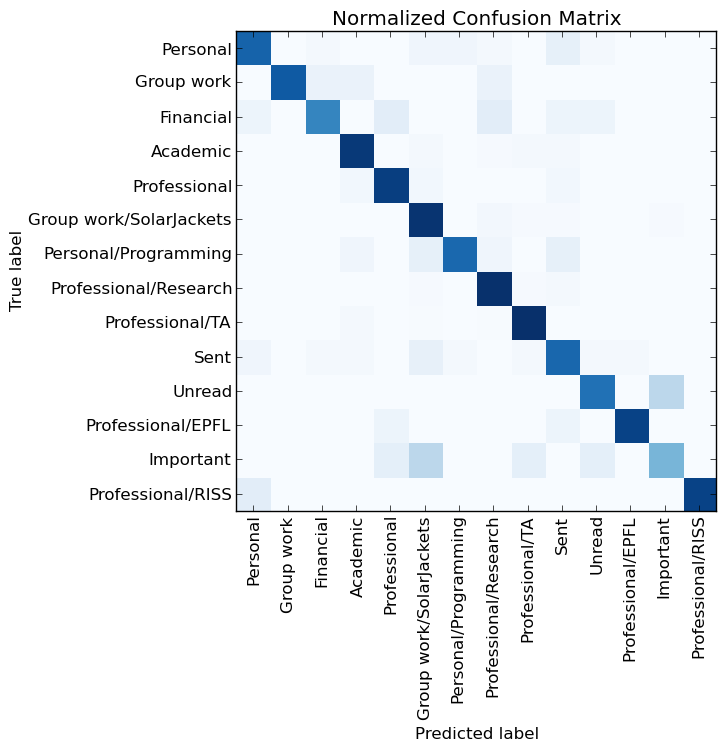

ニューラルネットワークの結果の誤差行列

素晴らしい、ほとんどのカラーブロックは斜めに配置されていますが、他にも「迷惑なスポット」がいくつかあります。 特に、視覚化では、カテゴリ「未読」と「重要」に問題があるとマークされます。 しかし、待ってください! これらのカテゴリは作成しませんでしたが、システムがそれらと送信済みカテゴリの両方をどれだけうまく処理できるかは気にしません。 間違いなく、それらを削除し、作成したカテゴリでニューラルネットワークが正確に機能することを確認する必要があります。

したがって、すべての不適切なカテゴリが存在せず、属性の最大数が使用される最後の実験を実行してみましょう-4,000の最良の選択で10,000ワード:

エポック1/5 5850/5850 [=======================================]-2秒-損失:0.8013-acc:0.7879-val_loss:0.2976- val_acc:0.9369 エポック2/5 5850/5850 [================================]-1秒-損失:0.1953-acc:0.9557-val_loss:0.2322- val_acc:0.9508 エポック3/5 5850/5850 [=======================================]-1秒-損失:0.0988-acc:0.9795-val_loss:0.2418- val_acc:0.9338 エポック4/5 5850/5850 [======================================]-1秒-損失:0.0609-acc:0.9865-val_loss:0.2275- val_acc:0.9462 エポック5/5 5850/5850 [===============================]-1秒-損失:0.0406-acc:0.9925-val_loss:0.2326- val_acc:0.9462 722/722 [===============================]-0s テストスコア:0.243211859068

精度:0.940443213296

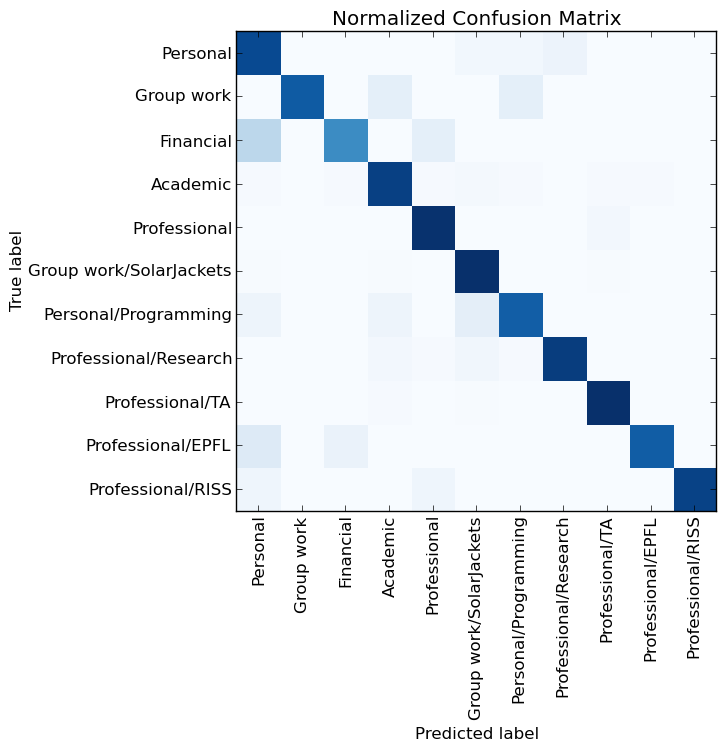

新しいニューラルネットワークの結果の誤差行列

行くぞ! ニューラルネットワークは、94%の精度でカテゴリを推測できます。 その効果は主に多数の属性セットによるものですが、優れた分類器(scikitがパッシブアグレッシブ分類器を学習する)自体は、同じ入力データに対して91%の精度を提供します。 実際、この場合、サポートベクターメソッド(LinearSVC)も効果的であるという考えがあります。これを使用すると、約94%の精度を得ることができます。

したがって、結論は非常に単純です。「トレンディな」機械学習法は、小さなデータセットでは特に効果的ではなく、N-gram + TF-IFD + SVMなどの古いアプローチは、最新のニューラルネットワークと同じように機能します。 つまり、文字数が少なく、上記の例と同じように明確にソートされていれば、Bag of Wordsメソッドを使用するだけで十分に機能します。

おそらく、Gmailでカテゴリを使用する人はほとんどいませんが、優れた分類子の作成が本当に簡単な場合、Gmailにワンクリックでメールを整理するための各文字のカテゴリを定義する機械学習システムがあればよいでしょう。 この段階で、Kurenkovは自分の結果を20%改善し、その過程でKerasに会ったことに非常に満足しています。

エピローグ:追加実験

実験に取り組んでいる間、エンジニアは別のことをしました。 彼は問題にぶつかりました。すべての計算は長時間にわたって実行されました。ほとんどの場合、素材の作者はGPUを使用して機械学習を開始するという今では普通のトリックを使用しなかったからです。 優れたリーダーシップの後、彼はこれを行い、素晴らしい結果を得ました。

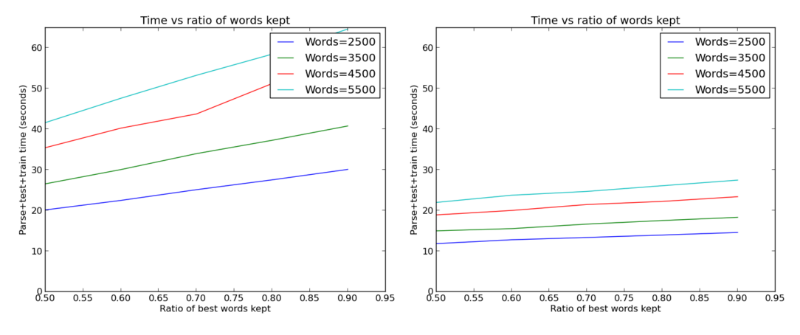

グラフィックプロセッサの有無にかかわらず、上記の90%を達成するのにかかる時間。 素晴らしい加速!

94%の精度を示すKerasニューラルネットワークは、サポートベクトル法に基づいたネットワーク学習よりもトレーニング(および操作)がはるかに高速であることに注意してください。 最初の試みは、私が試したすべての最善の解決策であることが判明しました。

エンジニアは、エラーマトリックス以外の何かを視覚化することを望んでいました。 この点で、著者は視覚化の問題に関する議論に出くわしましたが、Kerasではほとんど達成されていません。 これにより、学習プロセスを表示するための優れたオプションを備えたKerasの分岐点に至りました。 彼はあまり効果的ではありませんが、好奇心が強いです。 少し変更した後、彼は優れたトレーニングスケジュールを作成しました。

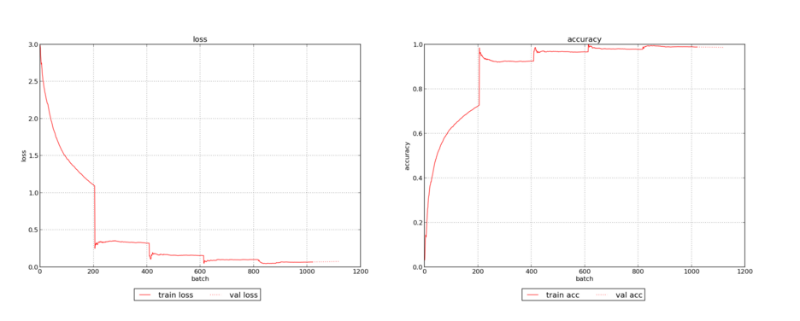

わずかに変更された例を使用したニューラルネットワークのトレーニングの進捗状況(多数の処理された単語を使用)

トレーニングの精度がどのように統一され、整合する傾向があるかを明確に示しています。

悪くはありませんが、エンジニアは精度の向上をより懸念していました。 以前と同様に、彼が最初に尋ねたのは、「ニューラルネットワークを支援するために文字の表示をすばやく変更することは可能ですか?」テキストをマトリックスに変換するKerasモジュールには、バイナリマトリックスの作成に加えて、単語数、頻度、またはTF値を持つマトリックスがいくつかあります-Idf。

行列に記号の形で格納されている単語の数を変更することも難しくありませんでした。そのため、Kurenkovは、記号の種類と単語の数がテストの精度にどのように影響するかを評価するサイクルをいくつか書きました。 興味深いスケジュールが判明しました:

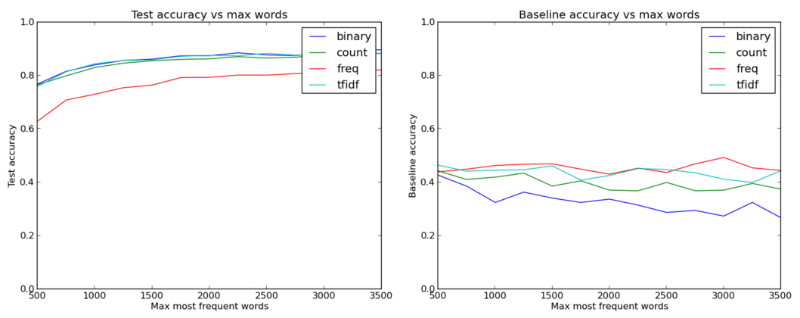

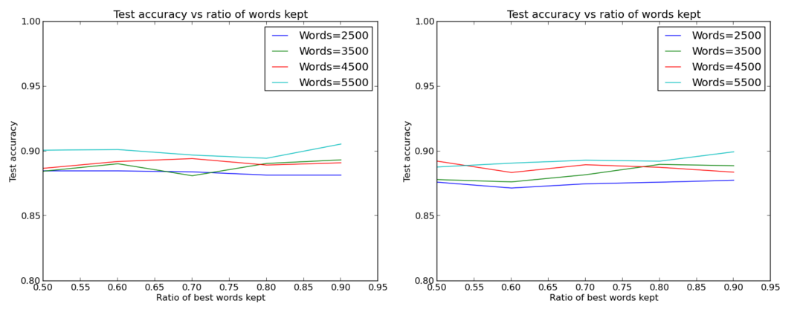

特徴のタイプと特徴として使用される単語の数に応じたテストの精度(基本的な精度は、最も近い「近傍」のkを考慮に入れます)

ここでは、単語の数を1,000を超える値に増やす必要があることが初めて明らかになりました。また、シンプルで最低の情報密度(バイナリ)を特徴とする機能の種類は、データに関する情報をより多く送信する他の種類よりも悪くなく、さらに良くなっていることがわかりました。

これはかなり予測可能ですが、おそらく「コード」や「グレード」などのより興味深い単語は文字を分類するのに役立ち、文字内の1つの出現は、多数の参照と同じくらい重要です。 疑いの余地なく、有益な機能の存在は有用かもしれませんが、再訓練の可能性の増加により、テスト結果を低下させる可能性もあります。

一般に、バイナリ記号は他の記号よりも優れていることがわかり、単語数を増やすと完全に87%〜88%の精度が得られます。

エンジニアはまた、基本的なアルゴリズムを調べて、k最近傍法( scikit )のようなものが(効率の観点から)ニューラルネットワークに相当しないことを確認しました-これは真実であることが判明しました。 線形回帰はさらに悪化したため、ニューラルネットワークの選択には十分な根拠があります。

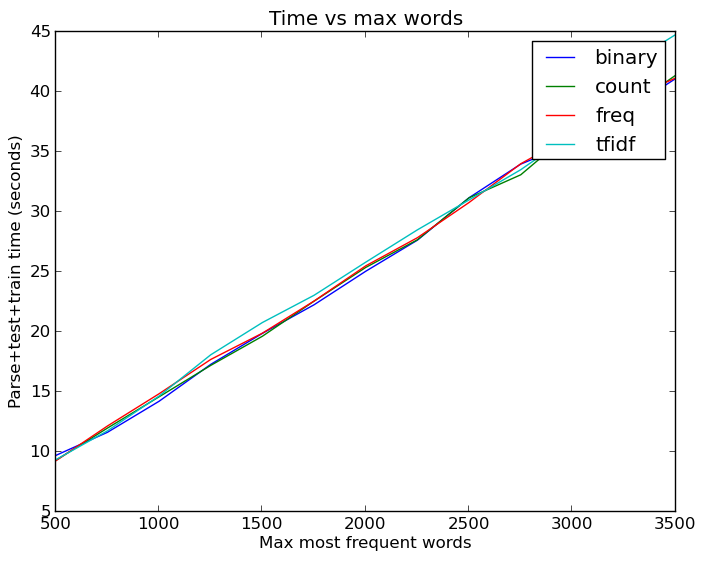

ところで、単語数の増加は無駄ではありません。 キャッシュされたバージョンのデータであっても、毎回メールを解析して属性を抽出する必要がなかった場合、これらすべてのテストの起動には多くの時間がかかりました。

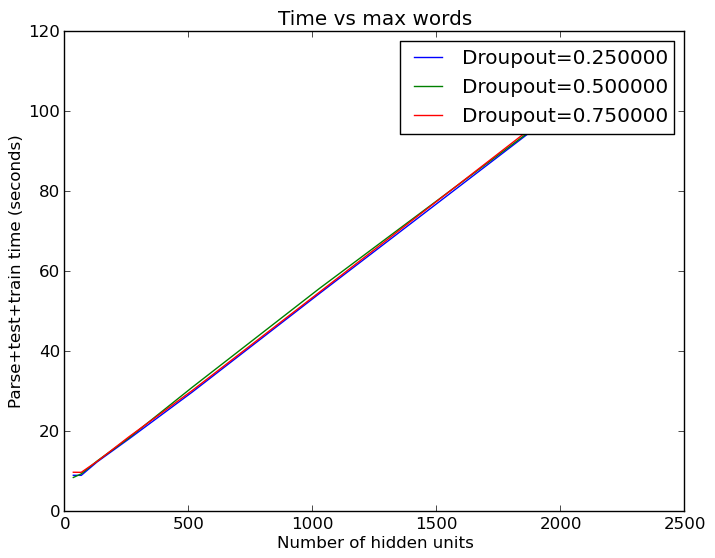

単語数に対する時間の増加の線形依存。 実際には悪くない、線形回帰ではずっと悪い

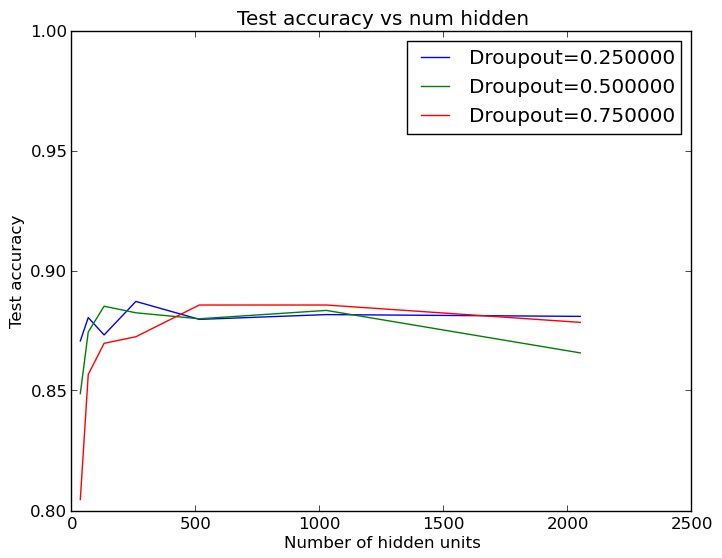

単語数の増加は助けましたが、実験者はまだ90%の望ましいしきい値に到達できませんでした。 したがって、次の考えは2,500ワードに固執し、ニューラルネットワークのサイズを変更しようとすることでした。 さらに、判明したように、Kerasの例のモデルでは、隠れ層で50%のドロップアウト正則化が行われています。エンジニアは、これによりネットワークの効率が本当に向上するかどうかを確認しました。 彼はループの別のセットを実行し、別の素晴らしいグラフを得ました:

さまざまなドロップアウト正則化オプションと非表示レイヤーサイズの精度グラフ

隠れ層のサイズは、すべてが正常に機能するのに十分な大きさである必要はないことがわかりました! 隠れ層の64または124個のニューロンは、標準の512と同様にタスクを実行できます。これらの結果は、5回の起動で平均化されるため、出力の小さな広がりは、小さな隠れ層の機能とは関係ありません。

したがって、有用な兆候を特定するためだけに多数の単語が必要になりますが、有用な兆候自体はそれほど多くありません。そうでなければ、より良い結果を得るには、より多くのニューロンが必要になります。 これは、小さな隠れ層を使用することで多くの時間を節約できるためです。

繰り返しますが、計算時間は隠れ層のニューロンの増加とともに直線的に増加します

しかし、これは完全に正確ではありません。 多くの兆候のあるより多くの実行を実行すると、エンジニアは、隠れ層の標準サイズ(512ニューロン)が小さい隠れ層よりもはるかに優れていることを発見しました。

それぞれ512および32個のニューロンを持つレイヤーのパフォーマンスの比較

すでに知られていることを述べることだけが残っています。言葉が多ければ多いほど良いです。