最初に、 PCA 、 ICA 、 NMF 、データの次元数を減らす方法について、正直かつ詳細に書きたいと思い、たくさんの数式をダンプし、この動物園全体でSVDが重要な役割を果たしていることを述べました。 それから、Mathgenの反対意見から切り抜きに似たテキストを取得することに気づいたので、式の数は最小限に抑えられましたが、最も好きなコードと写真を完全に残しました。

最初に、 PCA 、 ICA 、 NMF 、データの次元数を減らす方法について、正直かつ詳細に書きたいと思い、たくさんの数式をダンプし、この動物園全体でSVDが重要な役割を果たしていることを述べました。 それから、Mathgenの反対意見から切り抜きに似たテキストを取得することに気づいたので、式の数は最小限に抑えられましたが、最も好きなコードと写真を完全に残しました。

また、自動エンコーダーについて書くことも考えました。 Rでは、ご存じのとおり、問題はニューラルネットワークライブラリにあります: slow 、 buggy 、またはプリミティブです。 GPUを完全にサポートしていなければ(これはPythonと比較して非常に大きなRです)、あらゆる種類の複雑なニューラルネットワーク(特にディープラーニング )で作業することは実質的に意味がありません(開発中の有望なMXNetプロジェクトがあります)。 興味深いのは、比較的新鮮なh2oフレームワークであり、その著者は悪名高いTrevor Hastieから助言を受けており、Cisco、eBay、およびPayPalはそれを使用して人類を奴隷化する計画を作成します。 フレームワークはJavaで記述されています(はい、そして実際にRAMが大好きです)。 残念ながら、GPUでの作業もサポートしていません。 ターゲットオーディエンスはわずかに異なりますが、完全にスケーリングされ、RとPythonへのインターフェースを提供します(ただし、マゾヒズムのファンは、 localhost:54321でデフォルトでハングするWebインターフェースを使用することもできます) 。

そのため、データセットの測定数について疑問が生じた場合、これは非常に多くの測定値があることを意味し、機械学習アルゴリズムの使用があまり便利ではない理由です。 また、データの一部は単なる情報ノイズであり、無駄なゴミです。 したがって、最も価値のある測定値を可能な限り抽出して、不要な測定値を削除することをお勧めします。 ところで、逆の問題が発生する可能性があります-より多くの次元を追加するが、単により面白くて便利な機能。 専用コンポーネントは、視覚化の目的にも役立ちます(たとえば、 t-SNEはこれに対応しています)。 分解アルゴリズムは、教師なしの機械学習方法として、それ自体が興味深いものです。これは、主な問題の解決につながることもあります。

マトリックス分解

原則として、1つまたは別の効率でデータの次元を削減するために、機械学習のほとんどの方法を適応させることができます。実際、これらの方法は、1つの多次元空間を別の空間にマッピングします。 たとえば、PCAとK-meansの結果は、ある意味で同等です。 ただし、通常は、モデルパラメーターの検索で大騒ぎせずに、データの次元を削減する必要があります。 もちろん、これらのメソッドの中で最も重要なのはSVDです。 「なぜPCAではなくSVDなのですか?」とあなたは尋ねます。 SVDは、それ自体、データ分析において独立した重要な手法であり、分解の結果として得られる行列は、機械学習の観点から完全に意味のある解釈を持っているためです。 第二に、PCAに使用することができ、NMF (および他の行列分解法)のいくつかの予約で使用できます。 第三に、SVDはICAのパフォーマンスを改善するために適合させることができます。 さらに、SVDには、たとえば、正方( LU 、 Schurの分解)または正方対称正定行列( Cholesky )のみ、または要素が非負( NMF )の行列のみに適用できるなどの不快な特性はありません。 当然、普遍性の代価を払わなければなりません-特異分解はかなり遅いです。 したがって、行列が大きすぎる場合、 ランダム化されたアルゴリズムが使用されます。

SVDの本質は単純です-任意のマトリックス(実数または複素数)は、3つのマトリックスの積として表されます。

X =UΣV * 、

ここで、Uは次数mのユニタリ行列です。 Σはサイズmxnの行列で、その主対角には特異と呼ばれる非負の数があります(主対角の外側の要素はゼロに等しい-このような行列は長方形の対角行列と呼ばれることもあります)。 V *は、次数nのV行列のエルミート共役です。 行列Uのm列と行列Vのn列は、それぞれ行列Xの左特異ベクトルと右特異ベクトルと呼ばれます。測定数を減らす問題については、2番目に上がる要素が共通の原因に「入れられる」分散として解釈できる行列Σです。成分、降順:σ1≥σ2≥...≥σnoise。 したがって、SVDのコンポーネントの数を選択するとき(PCAの場合と同様)、考慮されるコンポーネントが与える分散の合計によって正確に導かれます。 Rでは、特異分解操作はsvd()関数によって実行され、特異値を持つベクトルdc、行列uおよびvの3つの要素のリストを返します。

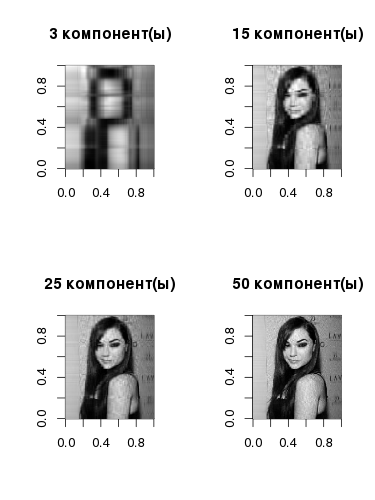

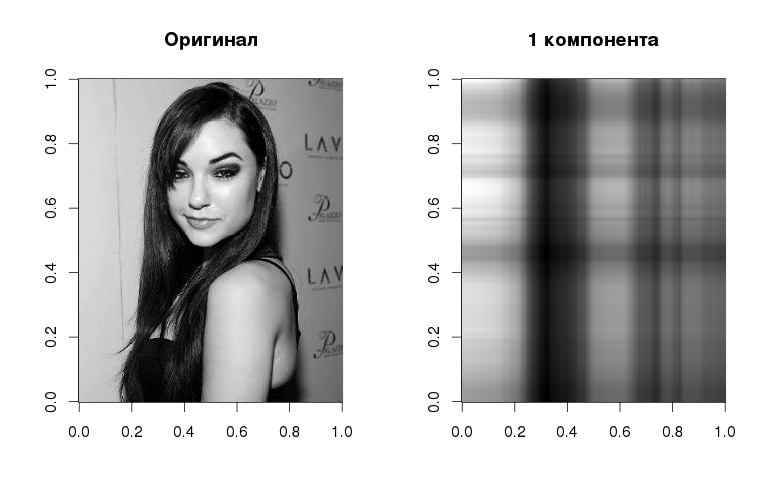

はい、それは1つのコンポーネントのみを備えた灰色のハーフトーンのサーシャのように見えますが、ここでは、元の画像のグラデーションに従って、基本的な線形化された構造を見ることができます。 コンポーネント自体は、左の特異ベクトルに対応する特異値と右の特異ベクトルを掛けると得られます。 ベクトルの数が増えると、画像再構成の品質も向上します。

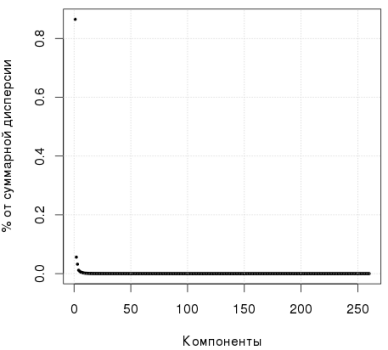

次のグラフは、最初のコンポーネントが分散の80%以上を説明していることを示しています。

Rコード、特異分解:

library(jpeg) img <- readJPEG("source.jpg") svd1 <- svd(img) # comp1 <- svd1$u[, 1] %*% t(svd1$v[, 1]) * svd1$d[1] par(mfrow=c(1,2)) image(t(img)[,nrow(img):1], col=gray(0:255 / 255), main="") image(t(comp1)[,nrow(comp1):1], col=gray(0:255 / 255), main="1 ") # par(mfrow=c(2,2)) for (i in c(3, 15, 25, 50)) { comp <- svd1$u[,1:i] %*% diag(svd1$d[1:i])%*% t(svd1$v[,1:i]) image(t(comp)[,nrow(comp):1], col=gray(0:255 / 255), main=paste0(i," ()")) } par(mfrow=c(1,1)) plot(svd1$d^2/sum(svd1$d^2),pch=19,xlab="",ylab="% ", cex=0.4) grid()

元の画像から各列の平均値を減算し、結果の行列を元の行列の列数の平方根に分割し、特異分解を実行するとどうなりますか? 結果の分解の行列Vの列は、PCAで取得された主要なコンポーネントに正確に対応することがわかります(ところで、PCAのRでは、prcomp()関数を使用できます)

> img2 <- apply(img, 2, function(x) x - mean(x)) / sqrt(ncol(img)) > svd2 <- svd(img2) > pca2 <- prcomp(img2) > svd2$v[1:2, 1:5] [,1] [,2] [,3] [,4] [,5] [1,] 0.007482424 0.0013505222 -1.059040e-03 0.001079308 -0.01393537 [2,] 0.007787882 0.0009230722 -2.512017e-05 0.001324682 -0.01373691 > pca2$rotation[1:2, 1:5] PC1 PC2 PC3 PC4 PC5 [1,] 0.007482424 0.0013505222 -1.059040e-03 0.001079308 -0.01393537 [2,] 0.007787882 0.0009230722 -2.512017e-05 0.001324682 -0.01373691

したがって、正規化された初期行列の特異分解を実行する場合、主成分を分離することは難しくありません。 これは、それらを計算する1つの方法です。 2番目は、共分散行列 XX Tの 固有ベクトルの検索に直接基づいています。

主成分の数を選択する問題に戻りましょう。 キャプテンのルールは次のとおりです。コンポーネントが大きいほど、より多くの差異が記述されます。 たとえば、 Andrew Ngは 、90%を超える分散に注目することを推奨しています。 他の研究者は、この数は50%であると主張しています。 ホーンのいわゆる並列分析でさえ、モンテカルロシミュレーションに基づいて発明されました。 このためのパッケージがRにあります。 非常に簡単なアプローチは、 スクリープロットを使用することです 。グラフ上で「肘」を探し、この「肘」の穏やかな部分を形成するすべてのコンポーネントを破棄する必要があります。 次の図では、6つのコンポーネントを考慮する必要があります。

一般的には、ご覧のとおりです。 質問はうまく解決されています。 また、PCAは正規分布のデータにのみ適用可能であると考えられていますが、 Wikiはこれに同意せず、SVD / PCAはあらゆる分布のデータで使用できますが、もちろん、必ずしも効率的ではありません(経験的に明らかにされています)。

もう1つの興味深い展開は、 非負行列の因数分解です 。これは、名前が示すとおり、非負行列を非負行列に分解するために使用されます。

X = WH

一般に、このような問題には(SVDとは異なり)正確な解決策がなく、計算には数値アルゴリズムが使用されます。 この問題は、 2次計画法で定式化できます。この意味では、 SVMに近くなります。 空間の次元を減らす問題では、次が重要です:行列Xの次元がmxnの場合、行列WとHの次元はそれぞれmxkとkxnであり、kの選択はmとn自体よりもはるかに小さいため、この初期次元を大幅に減らすことができます。 彼らは、非負行列がデータの性質とよく一致するテキストデータ分析に NMFを使用することを好みますが、一般に、 この手法の適用範囲は PCAに劣りません。 Rの最初の画像の分解により、次の結果が得られます。

R、NMFのコード:

library(NMF) par(mfrow=c(2,2)) for (i in c(3, 15, 25, 50)) { m.nmf <- nmf(img, i) W <- m.nmf@fit@W H <- m.nmf@fit@H X <- W%*%H image(t(X)[,nrow(X):1], col=gray(0:255 / 255), main=paste0(i," ()")) }

もっとエキゾチックなものが必要な場合

もともと加算成分で信号を分解するために開発された方法があります-私はICAについて話している。 この場合、これらのコンポーネントには異常な分布があり、そのソースは独立しているという仮説が受け入れられます。 最も単純な例は、多くの音声が混在するパーティです。タスクは、各ソースから各音声信号を分離することです。 通常、独立したコンポーネントの検索には2つのアプローチが使用されます。1) Kullback-Leibler発散に基づく相互情報量の最小化。 2)「非ガウス性」を最大化する(ここでは、過剰係数や負のエントロピーなどの尺度が使用されます )。

次の図では、2つの正弦波が混合されている単純な例で、ICAを使用してそれらも区別されています。

R、ICAのコード:

x <- seq(0, 2*pi, length.out=5000) y1 <- sin(x) y2 <- sin(10*x+pi) S <- cbind(y1, y2) A <- matrix(c(1/3, 1/2, 2, 1/4), 2, 2) y <- S %*% A library(fastICA) IC <- fastICA(y, 2) par(mfcol = c(2, 3)) plot(x, y1, type="l", col="blue", pch=19, cex=0.1, xlab="", ylab="", main=" ") plot(x, y2, type="l", col="green", pch=19, cex=0.1, xlab = "", ylab = "") plot(x, y[,1], type="l", col="red", pch=19, cex=0.5, xlab = "", ylab = "", main=" ") plot(x, y[,2], type="l", col="red", pch=19, cex=0.5, xlab = "", ylab = "") plot(x, IC$S[,1], type="l", col="blue", pch=19, cex=0.5, xlab = "", ylab = "", main="ICA") plot(x, IC$S[,2], type="l", col="green", pch=19, cex=0.5, xlab = "", ylab = "")

ICAは、データディメンションを削減するタスクと何の関係がありますか? その性質に関係なく、データをコンポーネントの混合物として提示してみましょう。この混合物を、私たちに合った数の「信号」に分割することができます。 PCAの場合のように、コンポーネントの数を選択するための特別な基準はありません-実験的に選択されます。

このレビューの最後の実験は自動エンコーダーです 。これは、 自動エンコーダーの出力での応答が入力信号に可能な限り近くなるように構成されたニューラルネットワークの特別なクラスです。 ニューラルネットワークのすべての能力と柔軟性により、最適なパラメーターを見つけることに関連する多くの問題も得られます:隠れ層とその中のニューロンの数、活性化関数( sigmoid 、 tanh 、 ReLu )、学習アルゴリズムとそのパラメーター、正則化の方法( L1 L2 、 ドロップアウト )。 ノイズの多いデータで自動エンコーダーをトレーニングして、ネットワークがそれを回復するようにすると、自動エンコーダーのノイズが除去されます。 事前設定された自動エンコーダーをカスケード形式で「ドッキング」して 、教師なしでディープネットワークを事前トレーニングすることもできます 。

最も単純な表現では、自動エンコーダーは多層パーセプトロンとしてモデル化できます。この場合、出力層のニューロンの数は入力の数に等しくなります。 下の図から、小さな次元の中間の隠れ層を選択することにより、初期データが「圧縮」されることが明らかです。

実際、上で述べたh2oパッケージには、このような自動アソシエーターが存在するため、使用します。 最初はジェスチャーを使って例を設定したかったのですが、すぐにいくつかの文章で

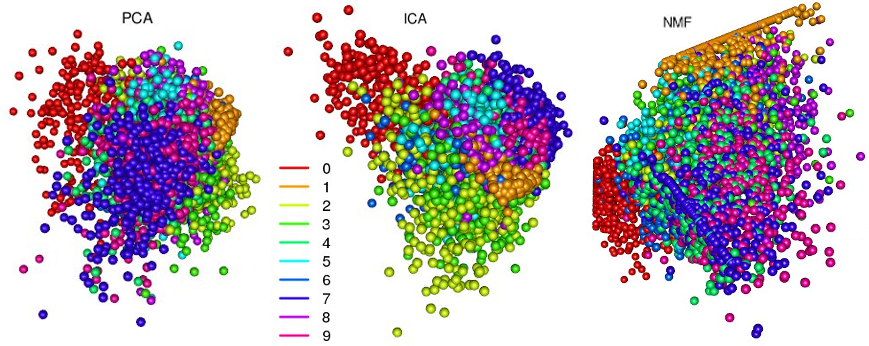

データは.csvファイル(train.csvおよびtest.csv)の形式で提示されますが、それらは非常に多くあるため、将来的にはtrain.csvのデータの10%を使用して単純化する予定です。 ラベルの付いた列は、視覚化の目的でのみ使用されます。 しかし、自動エンコーダーを使用して何ができるかを理解する前に、PCA、ICA、NMFを分解するときに最初の3つのコンポーネントが提供するものを見てみましょう。

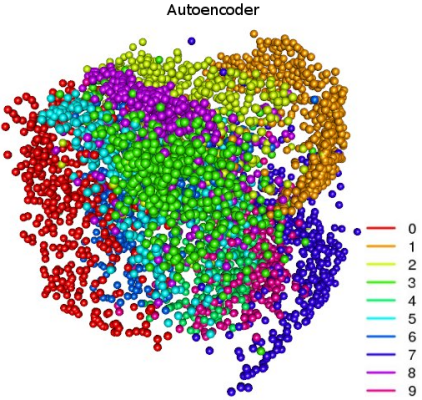

3つの方法はすべて、クラスタ化の優れた仕事をしました。画像では、はっきりと見えるグループが相互にスムーズに移行します。 これらの遷移は、数字の認識が特に困難な境界線の場合です。 PCAクラスターの図では、主成分法が重要な問題を解決する方法が非常に明確です。変数を非相関化します。クラスター「0」と「1」は最大間隔です。 NMFの「異常な」パターンは、メソッドが非負行列でのみ機能するという事実と正確に関連しています。 ただし、このようなセットの分離は、自動エンコーダーを使用して取得できます。

R、h2o自動エンコーダーのコード:

train <- read.csv("train.csv") label <- data$label train$label <- NULL train <- train / max(train) # library(caret) tri <- createDataPartition(label, p=0.1)$Resample1 train <- train[tri, ] label <- label[tri] # h2o library(h2o) h2o.init(nthreads=4, max_mem_size='14G') train.h2o <- as.h2o(train) # m.deep <- h2o.deeplearning(x=1:ncol(train.h2o), training_frame=train.h2o, activation="Tanh", hidden=c(150, 25, 3, 25, 150), epochs=600, export_weights_and_biases=T, ignore_const_cols=F, autoencoder=T) deep.fea <- as.data.frame(h2o.deepfeatures(m.deep, train.h2o, layer=3)) library(rgl) palette(rainbow(length(unique(labels)))) plot3d(deep.fea[, 1], deep.fea[, 2], deep.fea[, 3], col=label+1, type="s", size=1, box=F, axes=F, xlab="", ylab="", zlab="", main="AEC")

ここでは、クラスターがより明確に定義され、空間に間隔が空けられています。 このネットワークは、5つの隠れ層と少数のニューロンを含むかなり単純なアーキテクチャを備えています。 3番目の隠れ層には3つのニューロンしかなく、そこからの特徴は上に示したとおりです。 いくつかのより興味深い写真:

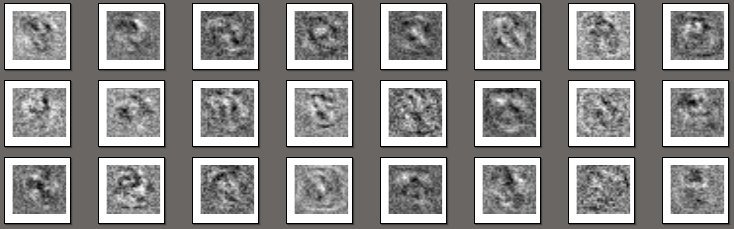

Rコード、最初の隠れ層の重みの視覚化:

W <- as.data.frame(h2o.weights(m.deep, 1)) pdf("fea.pdf") for (i in 1:(nrow(W))){ x <- matrix(as.numeric(W[i, ]), ncol=sqrt(ncol(W))) image(x, axes=F, col=gray(0:255 / 255)) } dev.off()

実際、これらはニューロンの重みの単なる画像です。各画像は個別のニューロンに関連付けられ、特定のニューロンに固有の情報を選択するフィルターを表します。 出力レイヤーのスケールの比較は次のとおりです。

前述の自動エンコーダーは、ノイズを除去する自動エンコーダーに簡単に変換できます。 このような自動エンコーダーは、歪んだ画像を入力に送信する必要があるため、最初の非表示レイヤーの前にドロップアウトレイヤーを配置するだけで十分です。 そのおかげで、ある程度の確率で、ニューロンは「オフ」状態になり、a)処理された画像に歪みが導入されます。 b)トレーニングの一種の正則化として機能します。

自動エンコーダの別の興味深いアプリケーションは、画像再構成のエラーに関するデータの異常の決定です。 一般に、トレーニングセットのデータがオートエンコーダーの入力に供給されない場合、もちろん、新しいサンプルからの各画像の再構成エラーは、トレーニングセットの再構成エラーよりも大きくなりますが、ほぼ同じ次数です。 異常がある場合、このエラーは数十または数百倍になります。

おわりに

もちろん、ある圧縮方法が他の圧縮方法よりも優れている、または劣っているという記述は誤りです。それぞれに固有の仕様と範囲があります。 多くはデータ自体の性質に依存します。 ここでの最後の役割は、アルゴリズムの速度ではありません。 上記のうち、最速のものがSVD / PCAであることが判明し、次にICA、NMFが順番に進み、自動エンコーダーがシリーズを完了します。 自動アソシエーターで作業することは特に困難です-特にパラメーターの選択が非自明であるため。