ストレージの観点から、最適化のオブジェクトは設定になります。

- ストレージ内のSAN

- イーサネットからストレージ

- ストレージ内のNAS

- バックエンドストレージ上のディスクサブシステム

- フロントエンドストレージのディスクサブシステム

- ファームウェアの互換性を確認する

- 加速器

ボトルネックを検索するには、通常、順次除外手法が実行されます。 最初にストレージから始めることをお勧めします 。 次に、 ストレージを移動します ->ネットワーク( イーサネット / FC)->ホスト( Windows / Linux / VMware ESXi 5.XおよびESXi 6.X )->アプリケーション。

NetAppの簡単な教育プログラム:

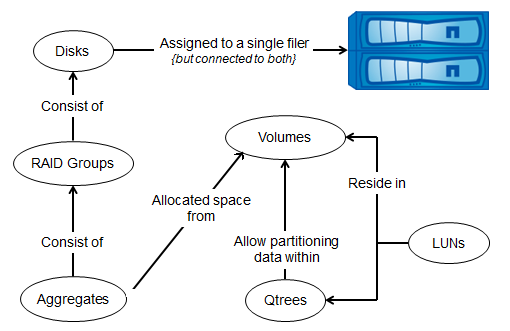

NetApp FAS ストレージシステムの内部構造のパラダイムを思い出させてください。これは、 FASシステムでほとんど常に観察される「シェアナッシング」イデオロギーによると、 ディスクはRAID グループ ( RAID-DP )で結合され、 RAIDグループはPlex (プレックスで結合されます。 ストレージシステム間のミラーリングの場合に使用されます RAID1の類似)、両方のPlexがAggregateに結合され、 FlexVolはAggregateで作成され、 FlexVolのデータはAggregateのすべてのドライブに均等に分散され、QtreeはFlexVolで作成されます (あらゆる種類のクォータを割り当てることができるフォルダーのようなもの)、Qtreeはできませんネストする場合、Qtree LUNの内部が作成されます。

NetApp FASストレージオブジェクト

ある時点では、1つのディスクは1つのコントローラーのみに属することができます。これは、DataONTAPの最も基本的なニーズであり、OSの奥深くに配線されています。 DataONTAPのディスクは、実際にはディスク全体でもパーティション(パーティション)でもかまいません。 つまり、そのようなオブジェクト(ディスク全体またはそのパーティション)の1つは常に所有権を持ち、ONペアの1つのコントローラーに対してのみ所有権を持ちます。 したがって、画像の単純さには注意を払えないニュアンスがあります:2番目のケースでは、1つの物理ディスクに複数のパーティションがあり、その所有権が割り当てられ、使用されるパーティションがあります-1つのコントローラー-他のパーティション-別のコントローラーがオンカップル。

そのため、ある時点では、「ディスク」(DataONTAPの観点から)、ムーン、ボリューム、およびアグリゲートは1つのコントローラーのみに属します。 ただし、この月へのアクセスは、 HAペアのパートナー、またはクラスターの他のノードを介しても可能です。 しかし、そのような月への最適なパスは常に、月-> volyum->ユニットが配置されているディスクを所有するコントローラーのポートを通過するパスのみです。 コントローラーに複数のポートがある場合、これらのポートはすべて、このコントローラーにある月への最適なパスです。 原則として、コントローラーのすべてのポートを介して月への可能なすべての最適なパスを使用すると、月へのアクセス速度にプラスの影響があります。 ホストは、すべての最適パスを同時に使用することも、最適パスの一部のみを使用することもできます。これは、そのようなホストのOSのマルチパス設定とストレージのポートセット設定に依存します。

Cluster-ModeのFASシステムの他のすべてのプロトコルにも同じことが当てはまります。最適なパスは、データが実際に配置されているコントローラーのポートを経由するパスです。 7-Modeでは、 CIFS / iSCSI / NFSプロトコルの最適でないパスを介したデータへのアクセスはありません。

したがって、 フロントエンドへのパスがストレージシステムへのすべてのアクセスプロトコルに対して常に最適であることを確認する必要があります。

したがって、 FC / FCoE / iSCSI プロトコルの場合、 ALUAメカニズムはこの問題を解決するのに役立ち、最適なパスがどこにあり、どこにないかをホストに伝え 、正しいマルチパス設定により、正常な動作で最適なパスのみが使用されるようにします。

NFSプロトコルでは、最適なパスの使用はRedHat LinuxですでにサポートされているpNFSで解決されました 。 これにより、クライアントは追加設定なしで自動的に最適なパスを理解し、切り替えることができます。 NFS v3.0プロトコルを使用したVMware ESXi 6.0仮想化環境の場合、ClusteredONTAPを備えたNetApp FASストレージでサポートされているvVolテクノロジーを使用して、最適パスの問題が実装されます。

CIFS (SMB)プロトコルの場合、バージョン3.0は、 SMB自動ロケーションメカニズムを実装します。これは、 pNFSと同様に、ファイル共有への最適なパスに切り替えます。

SANマルチパス

FC / FCoEで7-ModeおよびCluster-ModeでNetApp FASを使用する場合、 ALUAを有効にする必要があります。 7-ModeとCluster-ModeのiSCSIの設定は異なるため、最初のケースではALUAモードをオンにできませんでしたが、2番目のケースでは必要です。

マルチパスでは、デフォルトで優先パスを使用する必要があります。これは、 LUNへのパスであるLUNへのパスです。 FCP Partner Path Misconfigured ストレージコンソールのメッセージは、 不適切に構成された ALUAまたはMPIOを示します 。 これは重要なパラメーターです。激怒したホストマルチパッシングドライバーがパス間でノンストップを切り替え、I / Oシステムに大きなキューを作成する実際のケースが1つあったため、無視しないでください。

ポートセット

8ノード(4 ONペア)のFASシステムのSANクラスターサイズでは、月へのアクセスパス(したがってコントローラーのポート)の数は想像を超える数に達する可能性があります。 クラスター内のノードの数は増加するだけですが、頻繁に、フォールトトレランスを犠牲にすることなく、非常に妥当な数のプライマリパスとセカンダリパスに制限することができます。 したがって、 ポートセットはこの問題を解決し、特定のポートでのみ月を「見る」ことができます。 したがって、ムーンが見えるストレージポートを切り替えてスイッチ上で構成し、それに応じてゾーニングを構成する必要があります。

選択的LUNマップ

DataONTAP 8.3以降では、 SLM方式がデフォルトで使用され、月へのパスの数が2つのコントローラー(月を所有するコントローラーとHAペアのパートナー)に削減されます。 SLMメカニズムを使用してムーンを別のクラスターノードに移行する場合、ムーンを使用できるポートを指定するために管理者が追加の操作を行う必要はありません。すべてが自動的に行われます。 移行された衛星が利用できるLIFストレージインターフェイスのWWPNが 、スイッチの目的のゾーンに追加されるようにする必要があります。 対応するゾーン内のすべてのクラスターノードのすべての可能なWWPN をすぐに登録し、月へのパスが「十分に大きくない」ようにSLMメカニズムを処理することをお勧めし ます 。 詳細

オンライン移行とSLM

オンライン移行の場合、移行する月を受け入れるノードで、月が新しい追加の方法で利用できるようになったマルチパスホストのドライバーを「伝える」ことが必要です。

ゾーニング

NetApp + VMWare SANによるトラブルシューティングの詳細をご覧ください。 NetAppのゾーニングガイドラインの詳細については、写真をご覧ください。

イーサネット

Data Ontap 8.2.1以降、 DCB (ロスレス)イーサネットは、すべてのコンバージド( CNA / UTA )NetApp FASストレージポートでサポートされています。 イーサネットネットワークを設定するための推薦。

シンプロビジョニング

「ファイル」プロトコルNFSおよびCIFSを使用する場合、ファイル領域内の解放されたスペースを返すことにより、シンプロビジョニングテクノロジーの使用を利用することは非常に簡単です。 ただし、 SANの場合、ThinProvitioningを使用すると、空き領域を常に制御し、空き領域を解放する必要が生じます( SCSI-3メカニズムは最新のオペレーティングシステムで使用でき、Data Ontapではバージョン8.1.3以降で使用できます)。同じLUNには「入りません」ただし、このLUNを含むボリューム内。

NFS

10 GBE接続およびOracle データベースがある場合、 dNFSプロトコルを使用して接続する可能性を考慮することを強くお勧めします 。これは、NetApp内部テスト(他のストレージベンダーではこの状況が異なる場合がある)によると、 FC 8Gと比較した場合のパフォーマンスとレイテンシは同等またはわずかに優れているためですOLTPロード。 NFSは、仮想化にも非常に便利です。すべてのホストが「見る」すべての仮想マシンを備えた1つの大きなデータストアがあり、 SANネットワークでのゾーニングとは対照的に、ホスト間の移行、メンテナンス、ネットワークインフラストラクチャの構成を容易にします

また、仮想化中にシック仮想マシンディスクを作成し(負荷の高い環境でのVMWareベストプラクティスに従って)、同時にNFS経由で配信されるパフォーマンスと経済性の両方を備えたThin(ストアの観点から)データストアを持ち、両者間の妥協を行わないことは非常に便利です。 1つのデータストアを使用すると、空き領域をより効率的に分散し、より多くを必要とする仮想マシンにそれを提供し、 FCおよびiSCSIで発生する「量」を厳密に修正するのではなく、スペース節約を新しいレベルに引き上げることができます。 同時に、ブロックの重複排除や実装などによって解放された空きスペースは、このスペースを「戻し」、同じNFS / CIFSボールで使用できます。

ショーマウント

Linuxのshowmount -eコマンドは 、cDOT 8.3以降でサポートされています 。 showmount -eコマンドでNFSをデコードするには、ストレージ側からこの機能を有効にする必要があります。

nfs server modify -vserver * -showmount enabled

iSCSI

MS Windowsを使用する場合、 iSCSI MCSを使用できます。これにより、 1つのiSCSIセッション内で複数のTCP接続を使用できます。 MPIOとMCSを組み合わせると、パフォーマンスが大幅に向上します。

Windows 2008 R2およびFAS 3070のMCS / MPIOおよび10 GBEの異なるセッション数/ TCP接続でのスループット(MB / s)

| 接続数 | SQLIO NTFS MCS | SQLIO NTFS MPIO |

| 1 | 481 | 481 |

| 2 | 796 | 714 |

| 3 | 893 | 792 |

| 4 | 1012 | 890 |

| 5 | 944 | 852 |

| 6 | 906 | 902 |

| 7 | 945 | 961 |

| 8 | 903 | 911 |

Cifs

CIFS (SMB)3.0の新しいバージョンでは、このプロトコルをファイルトラッシュの目的だけでなく、MS SQLデータベースおよびMS Hyper-Vを備えた仮想マシンで使用するための新しい可能性を開きます。

継続的可用性共有(CA)は、プロトコルの機能を拡張します。 以前のバージョンでは、 フェイルオーバーまたはLIFが別のポートに移動した場合、クライアントはリポジトリへの再接続を強制されていました。 これで、 CAメカニズムにより、フェイルオーバーまたはLIFの移動時に接続がない場合、サービスを短時間中断することなくファイルを使用できます 。

VMWare VAAIおよびNFS

NetAppは、 NFSプロトコルを使用してVMWare ESXiのVAAIプリミティブをサポートしているため、ホストからストレージに 「ルーチンタスク」をダウンロードできます。 各ESXiホストにNFS VAAIプラグインをインストールする必要があります( FCプラグインには必要ありません)。CPUストレージ

ストレージシステムのすべてのコアを最適に使用するには、少なくとも8つのボリュームを使用します。これにより、並列化、使用率、および結果として作業速度が向上します。

香水

perfstatユーティリティは、 ストレージシステムの負荷をテキストファイルに収集します。 また、ユーティリティが実行されているホストから負荷に関する情報を同時に収集することもできます。 support.netapp.com Webサイトからダウンロード-ユーティリティToolChestセクションをダウンロードします(入力するにはNetApp NOW IDが必要です)。 ホストがストレージに十分なストレージを提供できないことがよくあるため、ロード時にストレージから統計を収集することが非常に重要です。これは、perfstatログから確認できます。この場合、複数のホストを使用する必要があります。

perfstat7.exe -f 192.168.0.10,192.168.0.12 -t 2 -i 3,0 -l root -S pw:123456 -F -I -w 1 >"20140114_1311.out"

このユーティリティを使用すると、たとえば、 破損したディスクがバックエンドおよびその結果フロント エンドでシステム全体の速度を落とす場合など、 ストレージ側の問題を含む、すべてのホストからのストレージシステムの総負荷を追跡できます。

perfstat出力の解釈

ホストとストレージシステムのテスト結果を比較すると、テスト中のシステムのボトルネックを見つけることができます。 したがって、以下のperfstatコマンドの出力によれば、 FCを使用してストレージシステムが十分にロードされていない( CPU 、ディスク使用率、および合計パラメーター)ことは明らかです。 このシステムでの操作のほとんどは、キャッシュの内容を読み取る形式で実行されます(値Cache hit)。 結論として、ホストはストレージシステムを十分にロードできません。

perfstat.out

テキストファイルを開きます 。

=-=-=-=-=-= PERF 192.168.0.12 POSTSTATS =-=-=-=-=-= Begin: Wed Jan 15 07:16:45 GMT 2014 CPU NFS CIFS HTTP Total Net kB/s Disk kB/s Tape kB/s Cache Cache CP CP Disk OTHER FCP iSCSI FCP kB/s iSCSI kB/s in out read write read write age hit time ty util in out in out 8% 0 0 0 227 1 1 2307 24174 0 0 8 89% 11% : 22% 3 224 0 12401 852 0 0 12% 0 0 0 191 1 5 3052 24026 0 0 6s 90% 14% F 27% 1 190 0 21485 864 0 0 18% 0 0 0 517 0 1 5303 46467 0 0 0s 90% 33% 2 38% 1 516 0 23630 880 0 0 15% 0 0 0 314 1 2 4667 24287 0 0 0s 91% 15% F 33% 27 287 0 27759 853 0 0 12% 0 0 0 252 0 1 3425 24601 0 0 9 91% 16% F 28% 20 232 0 22280 852 0 0 24% 0 0 0 1472 2 5 9386 46919 0 0 1s 82% 34% F 47% 9 1463 0 26141 673 0 0 14% 0 0 0 303 1 3 3970 24527 0 0 8s 90% 27% F 33% 1 302 0 22810 967 0 0 14% 0 0 0 299 2 6 3862 24776 0 0 0s 91% 21% F 29% 1 298 0 21981 746 0 0 13% 0 0 0 237 1 3 4608 24348 0 0 9 94% 15% F 30% 1 236 0 22721 958 0 0 17% 0 0 0 306 1 2 5603 48072 0 0 2s 92% 32% F 37% 1 305 0 22232 792 0 0 13% 0 0 0 246 0 1 3208 24278 0 0 8s 92% 14% F 26% 20 226 0 24137 598 0 0 -- Summary Statistics ( 11 samples 1.0 secs/sample) CPU NFS CIFS HTTP Total Net kB/s Disk kB/s Tape kB/s Cache Cache CP CP Disk OTHER FCP iSCSI FCP kB/s iSCSI kB/s in out read write read write age hit time ty util in out in out Min 8% 0 0 0 191 0 1 2307 24026 0 0 0s 82% 11% * 22% 0 190 0 0 0 0 0 Avg 14% 0 0 0 396 0 2 4490 30588 0 0 2 90% 21% * 31% 7 389 0 22507 821 0 0 Max 24% 0 0 0 1472 2 6 9386 48072 0 0 9 94% 34% * 47% 27 1463 0 27759 967 0 0 Begin: Wed Jan 15 07:18:36 GMT 2014

パラメーターCache age、Cache hit、CP tyの復号化。 パフォーマンスの最適化と狭いネック( ボトルネック )の発見についてもう少し。

ファイルシステム

ホストFSは、パフォーマンスのテスト時に大幅な調整を行うことができます。

FSブロックサイズは4KBの倍数である必要があります。 たとえば、生成されたOLTPに似た合成負荷を実行し、操作されるユニットのサイズが平均8Kである場合、8Kを設定します。 また、 FS自体として、特定のOSおよびバージョンへの実装が全体的なパフォーマンス状況に大きく影響する可能性があるという事実にも注意を喚起したいと思います。 したがって、 データベースからddファイルコマンドを使用して100 MBのブロックで10 MBをLUNにあるUFS FSに書き込むと、 FC 4Gを介してFAS 2240 ストレージと21 + 2 SAS 600 10kディスクを1ユニットで転送したデータの速度は150 MB / sでしたが、 FS ZFSを使用した同じ構成では、2倍(ネットワークチャネルの理論上の最大値に近づく)が示され、Noatimeパラメーターは状況にまったく影響しませんでした。

Noatime for file ball storage

また、アクセスされるデータを含むストレージセクションに同じパラメーターを設定する必要があります。 このオプションを有効にすると、 WAFL iノードのファイルアクセス時間が更新されなくなります。 したがって、次のコマンドはSMB CIFS / NFSファイルボールに適用できます。

vol options vol1 no_atime_update on

ずれ

どのOSでも、 LUNの作成時に正しいジオメトリを選択する必要があります。 FSブロックサイズが誤って指定されている場合、 LUNジオメトリが誤って指定されている場合、ホストでMBR / GPTパラメーターが正しく選択されていない場合、ピーク負荷時にコンソールで特定の「 LUNミスアライメント」イベントに関するメッセージが表示されます。 これらのメッセージは誤って表示される場合がありますが、まれにしか表示されない場合は、単に無視してください。 ストレージシステムでlun statsコマンドを実行することでこれを確認できます。以下に出力例を示します。align_histo.1:100%およびwrite_align_histo.1:97%に注意してください。これは、通常構成されたシステムではありません-ブロックはパラメーターで「0」で始まる必要がありますAlign_histo

TR-3593

適切なアライメントがないかどうかを判断するには、さまざまな方法があります。 wafl_suspセクションの下のperfstatカウンターを使用すると、「wp.partial_writes」、「pw.over_limit」、および「pw.async_read」が不適切なアライメントの指標になります。 「wp.partial write」は、アライメントされていないI / Oのブロックカウンターです。 少数の部分書き込み以上が発生すると、WAFLはバックグラウンド読み取りを開始します。 これらは「pw.async_read」でカウントされます。 「Pw.over_limit」は、ディスク読み取りで待機している書き込みのブロックカウンターです。

Data ONTAP 7.2.1以降を使用すると、I / Oアライメントを追跡するLUNごとのカウンターがいくつかあります。

read / write_align_histo [0]を除くこれらのいずれかがゼロ以外の場合、I / Oの位置がずれています。

Data ONTAP 7.2.1以降を使用すると、I / Oアライメントを追跡するLUNごとのカウンターがいくつかあります。

- lun:read_align_histo:I / OがWAFLブロックの先頭から512bセクター離れている数を追跡する読み取りの8binヒストグラム。 読み取りの割合として報告されます。

- lun:write_align_histo:書き込みと同じです。

- lun:read_partial_blocks:%4kの倍数ではない読み取り。

- lun:write_partial_blocks:書き込みでも同じです。

read / write_align_histo [0]を除くこれらのいずれかがゼロ以外の場合、I / Oの位置がずれています。

7-Modeのlun統計

priv set -q advanced; lun show -v lun status lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:display_name:/vol/vol0/drew_smi lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_ops:1/s lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_ops:26/s lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:other_ops:0/s lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_data:10758b/s lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_data:21997484b/s lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:queue_full:0/s lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:avg_latency:290.19ms lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:total_ops:27/s lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:scsi_partner_ops:0/s lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:scsi_partner_data:0b/s lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.0:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.1:100% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.2:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.3:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.4:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.5:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.6:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_align_histo.7:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.0:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.1:97% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.2:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.3:1% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.4:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.5:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.6:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_align_histo.7:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:read_partial_blocks:0% lun:/vol/vol0/drew_smi-W9mAeJb3vzGS:write_partial_blocks:1%

Cluster-Modeのlun show

cl1::*> set -privilege advanced; lun show -vserver <your_vserver> -path <your_path_to_the_lun> Vserver Name: vs_infra LUN Path: /vol/vol_infra_10/qtree_1/lun_10 Volume Name: vol_infra_10 Qtree Name: qtree_1 LUN Name: lun_10 LUN Size: 500.1GB Prefix Size: 0 Extent Size: 0 Suffix Size: 0 OS Type: vmware Space Reservation: disabled Serial Number: 804j6]FOQ3Ls Comment: Space Reservations Honored: true Space Allocation: disabled State: online LUN UUID: 473e9853-cc39-4eab-a1ef-88c43f42f9dc Mapped: mapped Vdisk ID: 80000402000000000000000000006a6a0335be76 Block Size: 512 Device Legacy ID: - Device Binary ID: - Device Text ID: - Read Only: false Inaccessible Due to Restore: false Inconsistent Filesystem: false Inconsistent Blocks: false NVFAIL: false Alignment: partial-writes Used Size: 89.44GB Maximum Resize Size: 4.94TB Creation Time: 10/31/2014 20:40:10 Class: regular Clone: false Clone Autodelete Enabled: false Has Metadata Provisioned: true QoS Policy Group: - cl1::*> set -privilege diagnostic; lun alignment show -vserver vs_infra -path * Vserver Name: vs_infra LUN Path: /vol/vol_infra_10/qtree_1/lun_10 OS Type: vmware Alignment: partial-writes Write Alignment Histogram: 62, 0, 0, 0, 0, 0, 0, 0 Read Alignment Histogram: 89, 0, 2, 0, 0, 0, 0, 0 Write Partial Blocks: 36 Read partial Blocks: 4 Vserver Name: vs_infra LUN Path: /vol/vol_0_a/lun_03032015_095833 OS Type: windows_2008 Alignment: aligned Write Alignment Histogram: 99, 0, 0, 0, 0, 0, 0, 0 Read Alignment Histogram: 99, 0, 0, 0, 0, 0, 0, 0 Write Partial Blocks: 0 Read partial Blocks: 0 Vserver Name: vs_infra LUN Path: /vol/vol_1_b/lun_03052015_095855 OS type: linux Alignment: misaligned Write alignment histogram percentage: 0, 0, 0, 0, 0, 0, 0, 100 Read alignment histogram percentage: 0, 0, 0, 0, 0, 0, 0, 100 Partial writes percentage: 0 Partial reads percentage: 0 Vserver Name: vs_infra LUN Path: /vol/vol_infra_20/qtree_2/lun_20 OS Type: linux Alignment: indeterminate Write Alignment Histogram: 0, 0, 0, 0, 0, 0, 0, 0 Read Alignment Histogram: 100, 0, 0, 0, 0, 0, 0, 0 Write Partial Blocks: 0 Read partial Blocks: 0

また、 VMFSを使用した「共有データストア」上の仮想化環境でもミスアライメントが発生する可能性があり、システムパフォーマンスの低下につながる可能性があります。 この場合、既存の仮想マシンの問題を修正するには2つの方法があります。vCenter用のNetApp VSCプラグインを介して、仮想マシン(Storage vMoution)の新しいデータストア(正しいLUNジオメトリ)への移行を開始するか、MBRalignコマンドラインユーティリティを使用して手動でブロックアライメントを実行しますvmdkファイル。 手動モードでは、仮想マシンOSのブートローダーが機能しなくなる可能性があり、復元する必要があることに注意してください。 詳細については、仮想環境でのファイルシステムアラインメントのベストプラクティスを参照してください 。 I / Oミスアライメントとは何か 、およびそれを修正する方法について は 、こちらをご覧ください。

再配分

たとえば、 作成済みのユニットにディスクを追加した後など、すべてのデータがすべてのディスクに分散していることを確認することが不可欠です。 ディスク上のボリュームデータの「スミア」状態を確認するには、7-Modeで実行します。

reallocate measure –o /vol/<volume>

Custered ONTAPの場合:

reallocate measure -vserver <vserver> -path /vol/<volume> -once true -threshold 3

そのようなコマンドの出力例を見てみましょう:

Sat Mar 1 20:26:16 EET [fas-a:wafl.reallocate.check.highAdvise:info]: Allocation check on '/vol/vol_vol01' is 12, hotspot 5 (threshold 4), consider running reallocate.

しきい値4より大きい12の値は、ボリュームで再配置を実行する必要があることを示します。 ホットスポット5の値は、ホットブロックがユニットのすべてのディスクではなく5つのディスクに配置されていることを示します(単純な実装で解決されない場合は、 こちらを参照してください )。

不十分な空き領域とスナップショットの存在により、実装が妨げられる場合があります 。 ボリュームでは、アクティブなファイルシステムに少なくとも5%、SnapReserveに10%の空き領域が必要です。

新しいディスクを追加する場合、データだけでなく空のブロックもアンバランスすることは理にかなっています。

ボリュームデータの物理的な実装を実行して、7-Modeのパフォーマンスを最適化する

aggr options aggr0 free_space_realloc on reallocate start -f -p /vol/<volume>

Clustered ONTAPで。 Clustered ONTAPの場合、 reallocateコマンドは出力を返しません。要求する必要があります。

storage aggregate modify -free-space-realloc on reallocate start -vserver <vserver> -path /vol/<volume> -force true -threshold 3 -space-optimized true event log show -messagename wafl.reallocate* -severity *

展開後のディスク負荷の均等分散:

ストレージ上のドライブを確認する

テスト中、ディスクの1つが故障していないか、ユニット全体にブレーキをかけないことを確認することが非常に重要です。

7-Modeの統計

# statit -b # statit -e disk ut% xfers ureads--chain-usecs writes--chain-usecs cpreads-chain-usecs greads--chain-usecs gwrites-chain-usecs /aggr0/plex0/rg0: 01.0a.16 9 3.71 0.47 1.00 90842 2.94 15.14 1052 0.30 7.17 442 0.00 .... . 0.00 .... . 01.0b.17 11 3.86 0.47 1.00 126105 3.14 14.31 1170 0.25 2.20 1045 0.00 .... . 0.00 .... . 01.0a.18 35 35.52 33.62 1.24 14841 1.63 26.23 965 0.27 15.09 392 0.00 .... . 0.00 .... . 01.0b.25 78 35.15 33.47 1.13 64924 1.48 28.77 2195 0.20 16.75 1493 0.00 .... . 0.00 .... . 01.0a.24 34 33.96 32.26 1.13 17318 1.51 28.21 1007 0.20 17.00 257 0.00 .... . 0.00 .... . 01.0b.22 36 35.40 33.67 1.15 16802 1.51 28.25 1003 0.22 15.56 721 0.00 .... . 0.00 .... . 01.0a.21 35 34.98 33.27 1.16 17126 1.48 28.75 950 0.22 14.78 820 0.00 .... . 0.00 .... . 01.0b.28 77 34.93 33.02 1.13 66383 1.56 27.40 3447 0.35 10.21 8392 0.00 .... . 0.00 .... . 01.0a.23 32 33.02 31.12 1.17 14775 1.53 27.65 1018 0.37 10.80 1321 0.00 .... . 0.00 .... . 01.0b.20 35 34.41 32.38 1.29 15053 1.66 25.73 976 0.37 9.67 1076 0.00 .... . 0.00 .... . 01.0a.19 34 34.80 33.07 1.20 15961 1.51 28.30 930 0.22 15.00 681 0.00 .... . 0.00 .... . 01.0b.26 76 34.41 32.41 1.05 68532 1.63 26.09 3482 0.37 11.93 7698 0.00 .... . 0.00 .... . 01.0a.27 36 35.15 33.32 1.26 15327 1.56 27.35 1018 0.27 12.82 1170 0.00 .... . 0.00 .... . /aggr0/plex0/rg1: 02.0b.29 5 2.00 0.00 .... . 1.63 27.89 1023 0.37 9.80 231 0.00 .... . 0.00 .... . 02.0a.33 5 2.03 0.00 .... . 1.68 27.13 1095 0.35 8.21 330 0.00 .... . 0.00 .... . 02.0b.34 32 34.46 32.75 1.19 14272 1.51 29.87 927 0.20 16.63 617 0.00 .... . 0.00 .... . 02.0a.35 31 32.85 31.00 1.15 14457 1.51 29.87 895 0.35 12.36 1075 0.00 .... . 0.00 .... . 02.0b.41 32 33.10 31.44 1.20 13396 1.51 29.87 930 0.15 21.83 618 0.00 .... . 0.00 .... . 02.0a.43 31 32.73 30.92 1.19 13827 1.58 28.47 1005 0.22 15.22 920 0.00 .... . 0.00 .... . 02.0b.44 31 32.65 31.02 1.11 14986 1.51 29.85 913 0.12 26.00 408 0.00 .... . 0.00 .... . 02.0a.32 31 32.68 30.87 1.13 14437 1.58 28.48 956 0.22 15.78 627 0.00 .... . 0.00 .... . 02.0b.36 32 34.70 32.95 1.13 14680 1.56 28.94 975 0.20 16.75 582 0.00 .... . 0.00 .... . 02.0a.37 31 32.43 30.70 1.21 13836 1.51 29.89 929 0.22 14.78 797 0.00 .... . 0.00 .... .

クラスターモードの統計/統計

または、 statisticsコマンドを使用します 。

# storage disk show -broken # run -node * -command "priv set diag; statit -b" # run -node * -command "priv set diag; statit -e" disk ut% xfers ureads--chain-usecs writes--chain-usecs cpreads-chain-usecs greads--chain-usecs gwrites-chain-usecs /aggr0/plex0/rg0: 01.0a.16 9 3.71 0.47 1.00 90842 2.94 15.14 1052 0.30 7.17 442 0.00 .... . 0.00 .... . 01.0b.17 11 3.86 0.47 1.00 126105 3.14 14.31 1170 0.25 2.20 1045 0.00 .... . 0.00 .... . 01.0a.18 35 35.52 33.62 1.24 14841 1.63 26.23 965 0.27 15.09 392 0.00 .... . 0.00 .... . 01.0b.25 78 35.15 33.47 1.13 64924 1.48 28.77 2195 0.20 16.75 1493 0.00 .... . 0.00 .... . 01.0a.24 34 33.96 32.26 1.13 17318 1.51 28.21 1007 0.20 17.00 257 0.00 .... . 0.00 .... . 01.0b.22 36 35.40 33.67 1.15 16802 1.51 28.25 1003 0.22 15.56 721 0.00 .... . 0.00 .... . 01.0a.21 35 34.98 33.27 1.16 17126 1.48 28.75 950 0.22 14.78 820 0.00 .... . 0.00 .... . 01.0b.28 77 34.93 33.02 1.13 66383 1.56 27.40 3447 0.35 10.21 8392 0.00 .... . 0.00 .... . 01.0a.23 32 33.02 31.12 1.17 14775 1.53 27.65 1018 0.37 10.80 1321 0.00 .... . 0.00 .... . 01.0b.20 35 34.41 32.38 1.29 15053 1.66 25.73 976 0.37 9.67 1076 0.00 .... . 0.00 .... . 01.0a.19 34 34.80 33.07 1.20 15961 1.51 28.30 930 0.22 15.00 681 0.00 .... . 0.00 .... . 01.0b.26 76 34.41 32.41 1.05 68532 1.63 26.09 3482 0.37 11.93 7698 0.00 .... . 0.00 .... . 01.0a.27 36 35.15 33.32 1.26 15327 1.56 27.35 1018 0.27 12.82 1170 0.00 .... . 0.00 .... . /aggr0/plex0/rg1: 02.0b.29 5 2.00 0.00 .... . 1.63 27.89 1023 0.37 9.80 231 0.00 .... . 0.00 .... . 02.0a.33 5 2.03 0.00 .... . 1.68 27.13 1095 0.35 8.21 330 0.00 .... . 0.00 .... . 02.0b.34 32 34.46 32.75 1.19 14272 1.51 29.87 927 0.20 16.63 617 0.00 .... . 0.00 .... . 02.0a.35 31 32.85 31.00 1.15 14457 1.51 29.87 895 0.35 12.36 1075 0.00 .... . 0.00 .... . 02.0b.41 32 33.10 31.44 1.20 13396 1.51 29.87 930 0.15 21.83 618 0.00 .... . 0.00 .... . 02.0a.43 31 32.73 30.92 1.19 13827 1.58 28.47 1005 0.22 15.22 920 0.00 .... . 0.00 .... . 02.0b.44 31 32.65 31.02 1.11 14986 1.51 29.85 913 0.12 26.00 408 0.00 .... . 0.00 .... . 02.0a.32 31 32.68 30.87 1.13 14437 1.58 28.48 956 0.22 15.78 627 0.00 .... . 0.00 .... . 02.0b.36 32 34.70 32.95 1.13 14680 1.56 28.94 975 0.20 16.75 582 0.00 .... . 0.00 .... . 02.0a.37 31 32.43 30.70 1.21 13836 1.51 29.89 929 0.22 14.78 797 0.00 .... . 0.00 .... .

または、 statisticsコマンドを使用します 。

set -privilege advanced ; statistics disk show -interval 5 -iterations 1 cl03 : 3/5/2015 10:30:29 Busy *Total Read Write Read Write Latency Disk Node (%) Ops Ops Ops (Bps) (Bps) (us) ----- --------------- ---- ------ ---- ----- ----- ----- ------- 1.0.4 Multiple_Values 1 5 2 3 31744 69632 6000 1.0.2 Multiple_Values 1 4 2 2 31744 65536 5263 1.0.8 Multiple_Values 0 2 1 1 62464 43008 5363 1.0.1 cl03-02 0 2 0 1 12288 7168 5500 1.0.0 cl03-02 0 2 0 1 12288 7168 5000 1.0.12 Multiple_Values 0 1 0 0 59392 53248 5000 1.0.10 Multiple_Values 0 1 0 0 60416 56320 6000 1.0.7 cl03-02 0 0 0 0 10240 0 0 1.0.6 cl03-02 0 0 0 0 11264 0 7500 1.0.5 cl03-02 0 0 0 0 10240 0 4000 1.0.3 cl03-02 0 0 0 0 10240 0 13000 1.0.17 cl03-02 0 0 0 0 10240 0 1000 1.0.16 cl03-01 0 0 0 0 10240 0 0 1.0.15 cl03-01 0 0 0 0 0 0 - 1.0.14 cl03-02 0 0 0 0 10240 0 0 1.0.11 cl03-02 0 0 0 0 10240 0 0

RAID-DP 11d + 2p構成では、アグリゲートが2つのRAIDグループ-rg0およびrg1で構成されていることがわかります。 ドライブ0c.16、1b.17および0c.29、0c.33はパリティディスクで、残りはデータです。

データディスクが均等にロードされていない場合

statit / statisticsコマンドの出力で、奇妙な点を探しています。 ディスクの使用量は、他のデータディスクと比較して0s.25、26、28です (パリティディスクには他のルールが適用されますが、それらは調べていません)。 グループディスクの平均ut ut負荷が35%の場合 、これらのディスクの負荷は、他のディスクと比較して、約75%に加えて高レイテンシ( usecs usecsおよびusecsを書き込む )のほぼ2倍、 60-70ミリ秒に達する残りは14-17です。 通常動作するアグリゲートでは、アグリゲート内のすべてのデータディスクに均等に負荷を分散する必要があります。 実装でユニットの負荷を調べるか、そのようなディスクを交換する必要があります。

7-Modeの場合:

disk fail 0.25

Cモードの場合:

storage disk fail –disk 0.25

次に、破損した7-Modeドライブを確認します

ディスクのLEDインジケータを強調表示して、検出とその後の抽出を容易にします

ディスクがインストールされているシェルフと位置の図を見てください。

aggr status -f sysconfig -d sysconfig -a disk show -v

ディスクのLEDインジケータを強調表示して、検出とその後の抽出を容易にします

led_on disk_name

ディスクがインストールされているシェルフと位置の図を見てください。

sasadmin shelf

破損したクラスターモードドライブを確認します

ディスクのLEDインジケータを強調表示して、検出とその後の抽出を容易にします

ディスクがインストールされているシェルフと位置の図を見てください。

storage aggregate show -state failed run -node * -command sysconfig -d run -node * -command sysconfig -a disk show -pool * -fields disk,usable-size,shelf,type,container-type,container-name,owner,pool disk show -prefailed true disk show -broken

ディスクのLEDインジケータを強調表示して、検出とその後の抽出を容易にします

storage disk set-led -disk disk_name 2

ディスクがインストールされているシェルフと位置の図を見てください。

run -node * -command sasadmin shelf

CPU負荷

CPUまたはキャッシュにプラグがないことを確認し、プロトコルの負荷を確認します。

7-Modeのsysstat

sysstatの詳細

7M> sysstat -x 1 CPU NFS CIFS HTTP Total Net kB/s Disk kB/s Tape kB/s Cache Cache CP CP Disk FCP iSCSI FCP kB/s iSCSI kB/s in out read write read write age hit time ty util in out in out 5% 0 726 0 726 2555 1371 2784 24 0 0 1 91% 0% - 89% 0 0 0 0 0 0 4% 0 755 0 755 1541 1136 3312 0 0 0 1 92% 0% - 89% 0 0 0 0 0 0 6% 0 1329 0 1334 3379 2069 3836 8 0 0 1 90% 0% - 79% 0 5 0 0 74 0 4% 0 637 0 637 2804 2179 3160 24 0 0 1 92% 0% - 86% 0 0 0 0 0 0 4% 0 587 0 587 2386 1241 2532 8 0 0 1 94% 0% - 98% 0 0 0 0 0 0 8% 0 381 0 381 2374 1063 5224 15120 0 0 6s 96% 45% Tf 78% 0 0 0 0 0 0 7% 0 473 0 473 2902 840 3020 20612 0 0 6s 98% 100% :f 100% 0 0 0 0 0 0 5% 0 1131 0 1133 3542 1371 2612 400 0 0 6s 92% 35% : 70% 0 2 0 0 20 0 7% 0 1746 0 1746 3874 1675 3572 0 0 0 6s 92% 0% - 79% 0 0 0 0 0 0 8% 0 2056 0 2056 5754 3006 4044 24 0 0 6s 95% 0% - 83% 0 0 0 0 0 0 6% 0 1527 0 1527 2912 2162 2360 0 0 0 6s 94% 0% - 86% 0 0 0 0 0 0 6% 0 1247 0 1265 3740 1341 2672 0 0 0 6s 94% 0% - 96% 0 18 0 0 98 0 6% 0 1215 0 1220 3250 1270 2676 32 0 0 6s 92% 0% - 86% 0 5 0 0 61 0 4% 0 850 0 850 1991 915 2260 0 0 0 6s 90% 0% - 75% 0 0 0 0 0 0 7% 0 1740 0 1740 3041 1246 2804 0 0 0 13s 92% 0% - 80% 0 0 0 0 0 0 3% 0 522 0 531 1726 1042 2340 24 0 0 16s 88% 0% - 69% 7 0 0 12 0 0 6% 0 783 0 804 5401 1456 3424 0 0 0 1 92% 0% - 89% 17 0 0 21 0 0 10% 0 478 0 503 4229 919 5840 13072 0 0 1 95% 65% Tf 98% 12 9 0 17 94 0 9% 0 473 0 487 3290 945 2720 23148 0 0 31s 97% 100% :f 100% 12 0 0 17 0 0 6% 0 602 0 606 3196 729 2380 12576 0 0 31s 97% 89% : 100% 0 0 0 0 0 0 10% 0 1291 0 1291 15950 3017 2680 0 0 0 31s 94% 0% - 100% 0 0 0 0 0 0 9% 0 977 0 977 13452 4553 4736 24 0 0 31s 96% 0% - 92% 0 0 0 0 0 0 6% 0 995 0 995 3923 2210 2356 8 0 0 31s 94% 0% - 85% 0 0 0 0 0 0 4% 0 575 0 583 1849 2948 3056 0 0 0 31s 93% 0% - 96% 0 8 0 0 111 0 5% 0 789 0 789 2316 742 2364 24 0 0 31s 94% 0% - 91% 0 0 0 0 0 0 4% 0 550 0 550 1604 1125 3004 0 0 0 31s 92% 0% - 80% 0 0 0 0 0 0 7% 0 1398 0 1398 2910 1358 2716 0 0 0 31s 94% 0% - 87% 0 0 0 0 0 0

sysstat / Cluster-Modeの統計

sysstatの詳細

またはコマンドを使用して

CM::*> system node run -node local -command "priv set diag; sysstat -x 1" CPU NFS CIFS HTTP Total Net kB/s Disk kB/s Tape kB/s Cache Cache CP CP Disk FCP iSCSI FCP kB/s iSCSI kB/s in out read write read write age hit time ty util in out in out 5% 0 726 0 726 2555 1371 2784 24 0 0 1 91% 0% - 89% 0 0 0 0 0 0 4% 0 755 0 755 1541 1136 3312 0 0 0 1 92% 0% - 89% 0 0 0 0 0 0 6% 0 1329 0 1334 3379 2069 3836 8 0 0 1 90% 0% - 79% 0 5 0 0 74 0 4% 0 637 0 637 2804 2179 3160 24 0 0 1 92% 0% - 86% 0 0 0 0 0 0 4% 0 587 0 587 2386 1241 2532 8 0 0 1 94% 0% - 98% 0 0 0 0 0 0 8% 0 381 0 381 2374 1063 5224 15120 0 0 6s 96% 45% Tf 78% 0 0 0 0 0 0 7% 0 473 0 473 2902 840 3020 20612 0 0 6s 98% 100% :f 100% 0 0 0 0 0 0 5% 0 1131 0 1133 3542 1371 2612 400 0 0 6s 92% 35% : 70% 0 2 0 0 20 0 7% 0 1746 0 1746 3874 1675 3572 0 0 0 6s 92% 0% - 79% 0 0 0 0 0 0 8% 0 2056 0 2056 5754 3006 4044 24 0 0 6s 95% 0% - 83% 0 0 0 0 0 0 6% 0 1527 0 1527 2912 2162 2360 0 0 0 6s 94% 0% - 86% 0 0 0 0 0 0 6% 0 1247 0 1265 3740 1341 2672 0 0 0 6s 94% 0% - 96% 0 18 0 0 98 0 6% 0 1215 0 1220 3250 1270 2676 32 0 0 6s 92% 0% - 86% 0 5 0 0 61 0 4% 0 850 0 850 1991 915 2260 0 0 0 6s 90% 0% - 75% 0 0 0 0 0 0 7% 0 1740 0 1740 3041 1246 2804 0 0 0 13s 92% 0% - 80% 0 0 0 0 0 0 3% 0 522 0 531 1726 1042 2340 24 0 0 16s 88% 0% - 69% 7 0 0 12 0 0 6% 0 783 0 804 5401 1456 3424 0 0 0 1 92% 0% - 89% 17 0 0 21 0 0 10% 0 478 0 503 4229 919 5840 13072 0 0 1 95% 65% Tf 98% 12 9 0 17 94 0 9% 0 473 0 487 3290 945 2720 23148 0 0 31s 97% 100% :f 100% 12 0 0 17 0 0 6% 0 602 0 606 3196 729 2380 12576 0 0 31s 97% 89% : 100% 0 0 0 0 0 0 10% 0 1291 0 1291 15950 3017 2680 0 0 0 31s 94% 0% - 100% 0 0 0 0 0 0 9% 0 977 0 977 13452 4553 4736 24 0 0 31s 96% 0% - 92% 0 0 0 0 0 0 6% 0 995 0 995 3923 2210 2356 8 0 0 31s 94% 0% - 85% 0 0 0 0 0 0 4% 0 575 0 583 1849 2948 3056 0 0 0 31s 93% 0% - 96% 0 8 0 0 111 0 5% 0 789 0 789 2316 742 2364 24 0 0 31s 94% 0% - 91% 0 0 0 0 0 0 4% 0 550 0 550 1604 1125 3004 0 0 0 31s 92% 0% - 80% 0 0 0 0 0 0 7% 0 1398 0 1398 2910 1358 2716 0 0 0 31s 94% 0% - 87% 0 0 0 0 0 0

またはコマンドを使用して

CM::*> set -privilege advanced ; statistics show-periodic cpu cpu total fcache total total data data data cluster cluster cluster disk disk pkts pkts avg busy ops nfs-ops cifs-ops ops recv sent busy recv sent busy recv sent read write recv sent ---- ---- -------- -------- -------- -------- -------- -------- ---- -------- -------- ------- -------- -------- -------- -------- -------- -------- 27% 88% 4 4 0 0 46.2KB 13.7KB 0% 35.4KB 2.36KB 0% 10.8KB 10.9KB 962KB 31.7KB 62 55 12% 62% 3 3 0 0 12.7KB 12.9KB 0% 207B 268B 0% 12.3KB 12.5KB 2.40MB 7.73MB 51 47 11% 41% 27 27 0 0 119KB 39.2KB 0% 104KB 25.6KB 0% 13.8KB 13.5KB 1.65MB 0B 155 116 cl03: cluster.cluster: 3/5/2015 10:16:17 cpu cpu total fcache total total data data data cluster cluster cluster disk disk pkts pkts avg busy ops nfs-ops cifs-ops ops recv sent busy recv sent busy recv sent read write recv sent ---- ---- -------- -------- -------- -------- -------- -------- ---- -------- -------- ------- -------- -------- -------- -------- -------- -------- Minimums: 11% 30% 1 1 0 0 12.7KB 12.9KB 0% 148B 245B 0% 10.8KB 10.9KB 947KB 0B 51 47 Averages for 12 samples: 20% 72% 7 7 0 0 58.5KB 20.4KB 0% 42.6KB 4.52KB 0% 15.7KB 15.7KB 1.57MB 4.06MB 105 90 Maximums: 30% 94% 27 27 0 0 145KB 39.2KB 0% 121KB 25.6KB 0% 23.9KB 24.4KB 3.06MB 12.4MB 198 177

ディスクサブシステムの最適化とチェックの詳細については、こちらをご覧ください。

ユニットのスナップショットを無効にする

ベストプラクティスで特に指定されていない限り、ユニットのスナップショットはオフにしてください。スナップショットは余分なスペースを占有し、SyncMirror(MetroCluster)などの非常にまれな構成で必要になります。

snap shced -A aggr1 0 0 0 snap delete -A aggr1 snap list -A aggr1 snap reserve -A aggr1 0

Clustered ONTAPの場合、各コマンドを追加する前に

system node run -node * -command

VSC L2キャッシュ:FlashCache / FlashPool

仮想ストレージ階層化(VST)-第2レベルのデータキャッシング。FlashCacheは、コントローラー上のすべての読み取り操作をキャッシュするPCIeカードです。FlashPool-回転ディスク(SAS / SATA HDD)とRAIDグループに割り当てられたSSDディスクで構成されるハイブリッドユニット、読み取り操作と上書き操作の両方をキャッシュします(書き込み操作は常にコントローラーのシステムキャッシュ、つまり最初のキャッシュにキャッシュされますレベル)。高価なアクセラレータを購入する前に、それが必要であるか、どのキャッシュサイズが最適かを確認する価値があります。これには次のメカニズムがあります。

- 用FlashCacheその予測キャッシュ統計(PCS)

- FlashPoolある高度なワークロード・アナライザ(AWA)

互換性

データセンターインフラストラクチャの潜在的な問題を軽減するために、実際に互換性マトリックスを広く適用します。新しい情報を受け取ったら、この記事に何か追加するものがあると確信しているので、フォロワーのために時々ここに立ち寄ってください。本文の誤りや提案についてはPMにコメントを送ってください。