私たちの潜在的な顧客のインフラストラクチャはすでに決着しており、機器の重大な変更は受け入れられないことがよくあります。 したがって、多くの新しいプロジェクトのフレームワーク内で、現在の機器の動作を最適化するタスクが発生します。

たとえば、顧客の1つである大規模な国内ソフトウェア会社は、かなり大きなサーバーとストレージシステムを保有しています。 含む-第6世代および第7世代のいくつかのHP ProLiantサーバーと、予備のHP EVAストレージシステム。 ソリューションが開発されなければならなかったのは彼らの基礎に基づいていました。

VDIソリューションの音声要件は次のとおりです。

- フローティングデスクトッププール(セッション終了後に変更を保存する);

- 初期構成は700ユーザーで、最大1000の内線があります。

最終的にリザーブからソリューションに移行するサーバーとストレージシステムの数を計算する必要がありました。

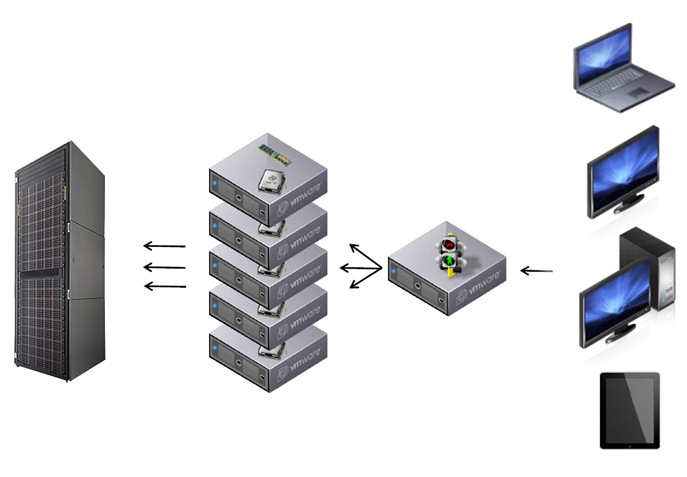

VMwareが仮想化環境として選択されました。 作業スキームは次のようになりました。

サーバーの1つは接続ブローカーとして機能し、クライアントはそれに接続します。 接続ブローカーは、セッションを提供する仮想マシンを起動する物理サーバーのプールから選択します。

残りのサーバーは、仮想マシンが実行されるESXハイパーバイザーとして機能します。

ESXハイパーバイザーは、仮想マシンイメージを保存するストレージシステムに接続します。

ESXハイパーバイザーには、6コアIntel Xeonプロセッサーを搭載した非常に強力なサーバーが割り当てられました。 一見したところ、「弱いリンク」はデータストレージシステムです。これは、VDIの隠れたキラーがIOPSであるためです。 しかし、もちろん、VDIソリューションを開発する際には、考慮すべき点が他にもたくさんあります。 それらのいくつかについて説明します。

- 覚えておく必要があるもの-ソリューションのコストの大部分はソフトウェアライセンスです。 ほとんどの場合、ハードウェアベンダーからのオファーを検討する方がより有益です。 仮想化ソフトウェアのOEMライセンスのコストは低くなります。

- 第二に、マルチメディアまたはグラフィックエディタで多数のユーザーと作業するためにグラフィックアクセラレータカードをインストールする可能性を検討する価値があります。

- HPの興味深いソリューションは、HP ProLiant WS460c Gen8ワークステーションブレードサーバーです。 その特徴的な機能:2つのハードドライブ、2つのプロセッサ、16のメモリスラットのスペースを失うことなく、グラフィックカードをブレードに直接取り付けることができます。 グラフィックアクセラレータは、最大240個のCUDAコア、2.0 GBのGDDR5メモリをサポートしています(興味深い記事はこちら )。

- 第三に、総所有コスト(TCO)を事前に計算する必要があります。 もちろん、機器の購入は大きな無駄ですが、ソリューションの実装による節約、更新と修復のコスト、およびソフトウェアライセンスの更新のコストを示すことができます。

最後に、 I / Oと主なI / Oの問題に進みましょう。

ハードドライブを備えたローカルPCで実行されているWindowsには、約40〜50 IOPSがあります。 サービスのセットが基本OSとともにそのようなPCにロードされるとき-プリフェッチ、インデックスサービス、ハードウェアサービスなど。 -多くの場合、これはユーザーにとって不要な機能ですが、パフォーマンスが大幅に低下することはありません。

ただし、VDIクライアントを使用すると、追加のサービスのほとんどすべてが非生産的です。速度と読み込み時間を最適化しようとして多数のI / O要求を生成しますが、効果は逆転します。

また、Windowsはデータブロックへのアクセスがほぼ一貫するようにデータブロックを最適化しようとしています。 ローカルハードドライブでは、シーケンシャルな読み取りと書き込みでハードドライブのヘッドの移動が少なくて済みます。 VDIについては、これに特別な注意を払う必要があります-投稿の終わりを参照してください。

クライアントが必要とするIOPSの数は、必要なサービスにより依存します。 平均して、この数値は10〜20 IOPSです(IOPSは、それぞれの場合に必要ですが、たとえばLiquidware Labsが提供するメカニズムを使用して測定できます)。 ほとんどのIOPSは書き込み操作です。 仮想インフラストラクチャでは、平均して読み取り/書き込み操作の比率が20/80に達する可能性があります。

このすべてが詳細に何を意味するのか:

1.ブート/ログオンストームの問題-キャッシュとポリシー、ポリシーとキャッシュ

その瞬間、ユーザーが自分の仮想マシンにアクセスして入ると、ディスクサブシステムに大きな負荷がかかります。 私たちのタスクは、この負荷を予測可能にすることです。つまり、そのほとんどを読み取り操作に減らしてから、通常の読み取りデータに専用キャッシュを効果的に使用します。

これを実現するには、クライアントの仮想マシンのイメージだけでなく、ユーザープロファイルも最適化する必要があります。 これを正しく構成すると、IOPSの負荷は予測可能な値になります。 正常に機能する仮想インフラストラクチャでは、読み込み時の読み取り/書き込み比率は90/10または95/5になります。

ただし、多数のユーザーが同時に作業を開始する場合、データストレージシステムは非常に大きくなります。そうしないと、一部のユーザーのログインプロセスに数時間かかる場合があります。 唯一の解決策は、同時接続の最大数を把握して、システムのボリュームを正しく計算することです。

たとえば、イメージが30秒間ロードされ、ピーク時にユーザーの同時接続数が合計の10%である場合、これにより、2倍の書き込み負荷と10倍の読み取り負荷が作成され、通常のストレージ負荷の36%になります。 同時接続数が3%の場合、ストレージシステムの負荷は通常の負荷と比較して11%しか増加しません。 私たちは顧客にアドバイスをします-遅刻を奨励します! (冗談)

ただし、ロードフェーズ後の読み取り/書き込みの割合が正反対に変わることを忘れないでください。読み取りIOPSはセッションあたり5 IOPSに低下しますが、書き込みIOPSの数は減少しません。 忘れてしまった場合、これは深刻な問題の始まりです。

2. OPSストレージシステム-適切なRAIDを選択する

ユーザーからの要求が共通のストレージシステム(SAN、iSCSI、SAS)に届くと、ストレージの観点からのすべての入出力操作は100%ランダムになります。 15,000 RPMの回転速度を備えたドライブのパフォーマンスは150-180 IOPSで、SAS / SATAストレージシステムでは、RAIDグループのディスク(ATAに属する、つまりRAIDのすべてのディスクが同期を待機している)は、IOPSよりも30%低いパフォーマンスを提供しますSAS / SATAドライブ1台。 比率は次のとおりです。

- RAID5の場合:ディスクから書き込みまで30-45 IOPS、読み取りまで160 IOPS。

- RAID1の場合:ディスクから書き込みまで70-80 IOPS、読み取りまで160 IOPS。

- ディスクから書き込みまでのRAID0 140-150 IOPS、読み取りから160 IOPS。

したがって、仮想化には、書き込みパフォーマンスの高いRAID(RAID1、RAID0)を使用することをお勧めします。

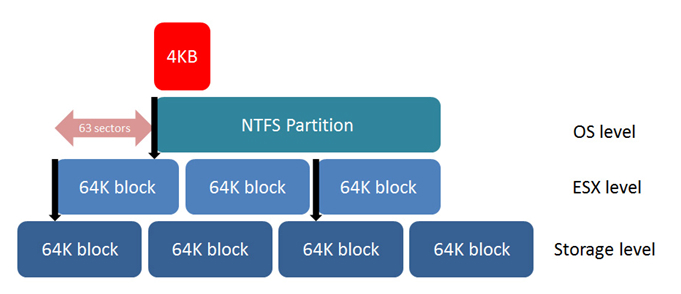

3.ディスク上の場所-アライメントが最も重要です

なぜなら ストレージシステムからの入出力操作を最小限に抑えたい-私たちの主なタスクは、各操作を最も効率的にすることです。 ディスク上の場所は、主な要因の1つです。 ストレージシステムから要求された各バイトは、他のバイトから個別に読み取られることはありません。 ベンダーに応じて、ストレージシステムのデータは32 KB、64 KB、128 KBのブロックに分割されます。 これらのブロックの上のファイルシステムがこれらのブロックと「整合」していない場合、ファイルシステム側からのIOPS要求1は、ストレージシステムからの2 IOPS要求を与えます。 このシステムが仮想ディスク上にあり、このディスクがアライメントされていないファイルシステム上にある場合、この場合オペレーティングシステムに1 IOPSを要求すると、ファイルシステムに3 IOPSが要求されます。 これは、すべてのレベルでの調整が最も重要であることを示しています。

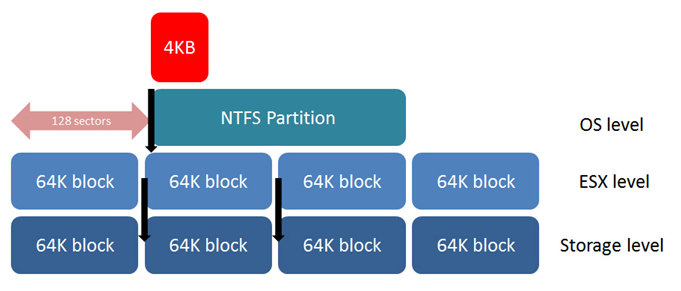

残念ながら、Windows XPおよびWindows 2003は、オペレーティングシステムのインストール中にディスクの最初の部分に署名を作成し、最初のブロックの最後のセクターで記録を開始します。これにより、ストレージシステムブロックに対してOSファイルシステムが完全にシフトします。 これを修正するには、diskpartまたはfdiskユーティリティを使用して、ホストまたは仮想マシンに提示されるパーティションを作成する必要があります。 セクター128から記録の開始を割り当てます。セクターは512バイトであり、記録の開始を64KBマーカーに正確に設定します。 パーティションが調整されると、ファイルシステムからの要求ごとにストレージシステムから1 IOPSを受け取ります。

VMFSについても同じことが言えます。 ESXサービスコンソールを使用してパーティションを作成すると、デフォルトではストレージシステムと一致しません。 この場合、fdiskを使用するか、VMware vCenterを介してパーティションを作成する必要があります。これにより、アライメントが自動的に実行されます。 Windows Vista、Windows 7、Windows Server 2008以降の製品は、デフォルトでパーティションを1 MBに調整しようとしますが、自分で調整を確認することをお勧めします。

アライメントによるパフォーマンスの向上は、大きなファイルでは約5%、小さなファイルやランダムIOPSでは30〜50%です。 また、ランダムIOPSの負荷はVDIの特徴であるため、調整が非常に重要です。

4.最適化とプリフェッチを無効にする必要があります

NTFSファイルシステムは4KBブロックで構成されています。 幸いなことに、Windowsはアクセスができるだけ一貫するようにブロックを配置しようとします。 ユーザーがアプリケーションを起動すると、リクエストは読み取られるのではなく書き込まれます。 デフラグプロセスは、データの読み取り方法を推測しようとしています。 この場合、デフラグメンテーションは、顕著なプラス効果を与えることなくIOに負荷をかけます。 したがって、VDIソリューションの最適化プロセスを無効にすることをお勧めします。

プリフェッチプロセスについても同様です。 プリフェッチは、ほとんどの場合アクセスされるファイルを特別なWindowsキャッシュディレクトリに配置するプロセスで、これらのファイルの読み取りに一貫性があり、IOPSが最小限に抑えられます。 ただし、多数のユーザーからの要求により、ストレージの観点からIOPSが完全にランダムになるため、プリフェッチプロセスには利点がなく、入出力トラフィックのみが無駄になります。 終了-プリフェッチ機能を完全に無効にする必要があります。

ストレージシステムが重複排除を使用する場合、これはプリフェッチおよびデフラグ機能を無効にすることを支持するもう1つの引数です-プリフェッチプロセス、ファイルを1つのディスクから別のディスクに移動すると、重複排除プロセスの効率が大幅に低下します。めったに変更されないディスクデータブロックのテーブルを保存することが重要です。