ये सभी प्रौद्योगिकियां अच्छी और उत्सुक हैं, लेकिन हर छींक से प्रचार कहां है?

क्या होगा अगर मैं कहता हूं कि पिछले 10 वर्षों में, 3 डी शूटिंग तकनीक का आविष्कार, विकास और बड़े पैमाने पर उत्पादन में किया गया था, जो किसी भी अन्य से बहुत अलग है? इसके अलावा, प्रौद्योगिकी पहले से ही सार्वभौमिक रूप से उपयोग की जाती है। दुकानों में आम लोगों के लिए डिबग और सुलभ। क्या आपने उसके बारे में सुना है? (शायद केवल रोबोटिक्स और विज्ञान के संबंधित क्षेत्रों के विशेषज्ञों ने पहले ही अनुमान लगा लिया है कि मैं टीओएफ कैमरों के बारे में बात कर रहा हूं)।

ToF कैमरा क्या है? रूसी विकिपीडिया ( अंग्रेजी ) में आपको इसका संक्षिप्त उल्लेख भी नहीं मिलेगा कि यह क्या है। "फ्लाइट कैमरा का समय" "टाइम-ऑफ़-फ़्लाइट कैमरा" में बदल जाता है। कैमरा प्रकाश की गति के माध्यम से सीमा निर्धारित करता है, कैमरे द्वारा उत्सर्जित प्रकाश संकेत की उड़ान के समय को मापता है, और प्राप्त छवि के प्रत्येक बिंदु पर परिलक्षित होता है। आज का मानक 320 * 240 पिक्सेल मैट्रिक्स है (अगली पीढ़ी 640 * 480 होगी)। कैमरा 1 सेंटीमीटर के क्रम की गहराई माप की सटीकता प्रदान करता है। हाँ, हाँ। 76800 सेंसर का एक मैट्रिक्स, 1 / 10,000,000,000 (10 ^ -10) सेकंड के आदेश की समय सटीकता प्रदान करता है। बिक्री पर। 150 रुपये के लिए। या शायद आप भी इसका इस्तेमाल करते हैं।

और अब भौतिकी के बारे में थोड़ा और काम के सिद्धांत, और जहां आप इस सुंदरता से मिले।

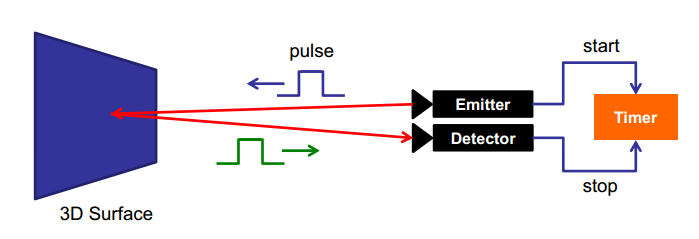

तीन मुख्य प्रकार के टीओएफ कैमरे हैं। प्रत्येक प्रकार एक बिंदु की सीमा को मापने के लिए अपनी तकनीक का उपयोग करता है। सबसे सरल और सबसे समझने योग्य है पल्स्ड मॉड्यूलेशन, जिसे डायरेक्ट टाइम-ऑफ-फ्लाइट इमेजर्स के रूप में भी जाना जाता है। आवेग दिया जाता है और इसके लौटने का सही समय मैट्रिक्स के प्रत्येक बिंदु पर मापा जाता है:

वास्तव में, मैट्रिक्स में ट्रिगर्स होते हैं जो तरंग के साथ आग लगाते हैं। फ्लैश के लिए ऑप्टिकल सिंक्रनाइज़ेशन में एक ही विधि का उपयोग किया जाता है। केवल यहां परिमाण के आदेश अधिक सटीक हैं। यह इस पद्धति की मुख्य कठिनाई है। प्रतिक्रिया समय की बहुत सटीक पहचान की आवश्यकता होती है, जिसके लिए विशिष्ट तकनीकी समाधान की आवश्यकता होती है (जो मुझे नहीं मिला)। अब ऐसे सेंसर का परीक्षण नासा द्वारा उसके जहाजों के लैंडिंग मॉड्यूल के लिए किया जा रहा है।

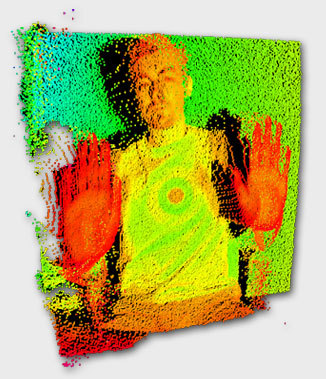

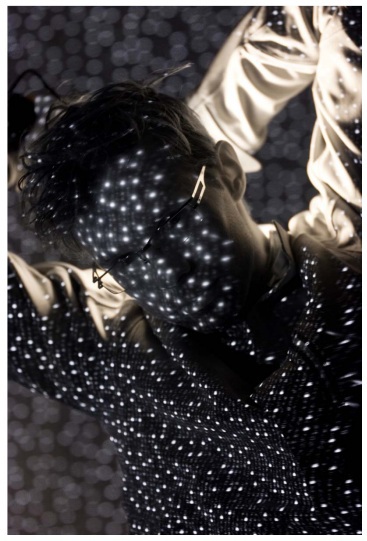

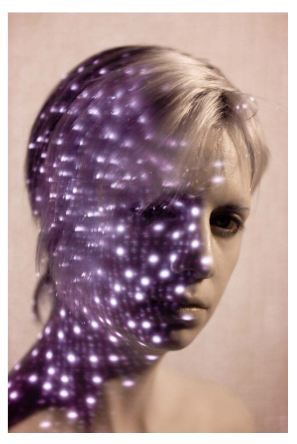

और यहाँ वह तस्वीरें हैं जो वह देती हैं:

उनके लिए पर्याप्त बैकलाइट है ताकि ट्रिगर लगभग 1 किलोमीटर की दूरी से परिलक्षित ऑप्टिकल धारा द्वारा ट्रिगर हो। ग्राफ मैट्रिक्स में ट्रिगर पिक्सल की संख्या को दर्शाता है, 1 किमी की दूरी पर 90% काम के आधार पर:

दूसरा तरीका सिग्नल का निरंतर मॉड्यूलेशन है। एमिटर कुछ संग्राहक लहर भेजता है। रिसीवर इस तरंग के साथ जो देखता है उसका अधिकतम सहसंबंध पाता है। यह उस समय को निर्धारित करता है जो सिग्नल रिसीवर को प्रतिबिंबित करने और पहुंचने में खर्च करता है।

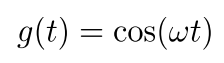

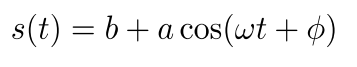

संकेत उत्सर्जित होने दें:

जहां w मॉड्यूलेटिंग फ्रीक्वेंसी है। तब प्राप्त संकेत इस तरह दिखाई देगा:

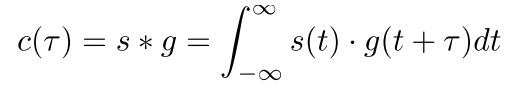

जहाँ b एक निश्चित बदलाव है, एक आयाम है। इनकमिंग और आउटगोइंग सिग्नल का सहसंबंध:

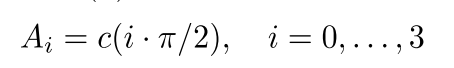

लेकिन हर संभव समय बदलाव के साथ एक पूर्ण सहसंबंध प्रत्येक पिक्सेल में वास्तविक समय में उत्पादन करना काफी मुश्किल है। इसलिए, कानों के साथ एक मुश्किल झगड़े का उपयोग किया जाता है। प्राप्त संकेत 4 पड़ोसी पिक्सल में 90 phase चरण की पारी के साथ प्राप्त होता है और स्वयं के साथ सहसंबंधित होता है:

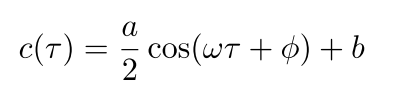

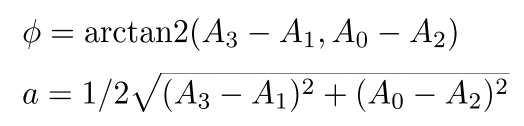

फिर चरण शिफ्ट को इस प्रकार परिभाषित किया गया है:

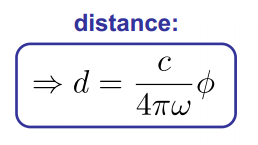

प्राप्त चरण शिफ्ट और प्रकाश की गति को जानने के बाद, हम वस्तु से दूरी प्राप्त करते हैं:

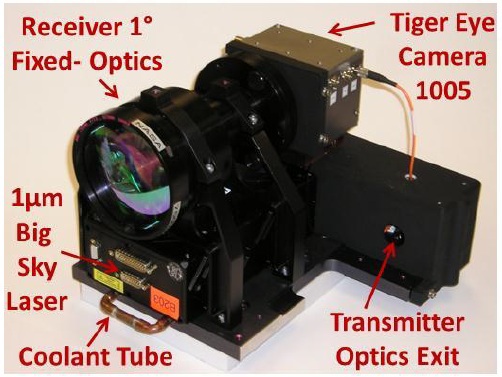

ये कैमरे पहले तकनीक के साथ निर्मित की तुलना में थोड़ा सरल हैं, लेकिन अभी भी जटिल और महंगे हैं। यह कंपनी उन्हें बनाती है। और इनकी कीमत लगभग 4 किलोबैक्स होती है । लेकिन प्यारा और भविष्य:

तीसरी तकनीक है रेंज गेटेड इमेजर्स। अनिवार्य रूप से एक शटर कैमरा। यहाँ विचार बहुत ही सरल है और इसके लिए उच्च परिशुद्धता प्राप्तियों या जटिल सहसंबंध की आवश्यकता नहीं है। मैट्रिक्स से पहले एक शटर है। मान लीजिए कि हमारे पास यह सही है और तुरन्त काम करता है। समय 0 पर, दृश्य प्रकाश चालू है। शटर समय टी पर बंद हो जाता है। तब टी / (2, c) की तुलना में दूर स्थित वस्तुएं, जहां c प्रकाश की गति है, दिखाई नहीं देगी। प्रकाश के पास अभी उन तक पहुंचने और वापस जाने का समय नहीं है। कैमरे के पास स्थित एक बिंदु को पूरे एक्सपोज़र टाइम टी में रोशन किया जाएगा और आई की चमक होगी। इसलिए, किसी भी एक्सपोज़र पॉइंट में 0 से आई की चमक होगी, और यह चमक बिंदु की दूरी का प्रतिनिधित्व करेगी। उज्जवल - करीब।

यह केवल कुछ चीजों को करने के लिए रहता है: इस घटना में शटर क्लोजर समय और मैट्रिक्स व्यवहार का परिचय दें, गैर-आदर्श प्रकाश स्रोत (एक बिंदु प्रकाश स्रोत के लिए, सीमा और चमक रैखिक नहीं होगी), सामग्री की अलग-अलग परावर्तनशीलता। ये बहुत बड़े और जटिल कार्य हैं जिन्हें डिवाइस लेखकों ने हल किया है।

ऐसे कैमरे सबसे अधिक गलत हैं, लेकिन सबसे सरल और सबसे सस्ता: उनमें जटिलता एल्गोरिथ्म है। एक उदाहरण चाहते हैं कि ऐसा कैमरा कैसा दिखता है? यहाँ यह है:

हाँ, हाँ, दूसरे Kinect में बस एक ऐसा कैमरा है। बस पहले के साथ दूसरे Kinect को भ्रमित न करें (हब पर एक बार एक अच्छा और विस्तृत लेख था जहां उन्होंने अभी भी इसे मिलाया है)। पहले Kinect संरचित हाइलाइटिंग का उपयोग करता है । यह अधिक पुरानी, कम विश्वसनीय और धीमी तकनीक है:

यह एक पारंपरिक अवरक्त कैमरा का उपयोग करता है जो अनुमानित पैटर्न को देखता है। इसकी विकृतियां सीमा निर्धारित करती हैं (विधियों की तुलना यहां पाई जा सकती है )।

लेकिन Kinect बाजार पर एकमात्र प्रतिनिधि से बहुत दूर है। उदाहरण के लिए, इंटेल $ 150 के लिए एक कैमरा जारी करता है, जो एक 3 डी इमेज कार्ड देता है। यह करीब क्षेत्र पर केंद्रित है, लेकिन फ्रेम में इशारों का विश्लेषण करने के लिए उनके पास एसडीके है। यहां सॉफ्टकाइनेटिक का एक और विकल्प है (उनके पास एक एसडीके भी है, साथ ही वे किसी तरह टेक्सास इंस्ट्रूमेंट्स से बंधे हैं)।

हालाँकि, मैं अभी भी इनमें से किसी भी कैमरे का सामना नहीं कर पाया हूँ, जो दयनीय और कष्टप्रद है। लेकिन, मुझे लगता है और उम्मीद है कि पांच साल में वे उपयोग में आ जाएंगे और मेरी बारी आएगी। जहां तक मुझे पता है, वे सक्रिय रूप से रोबोट के अभिविन्यास के लिए उपयोग किए जाते हैं, उन्हें चेहरे की पहचान प्रणालियों में पेश किया जाता है। कार्यों और अनुप्रयोगों की सीमा बहुत विस्तृत है।